Шкідливі боти на сайті – як їх виявити та заблокувати

Чи знаєте ви, що значну частину онлайн-трафіку створюють боти? Ці автоматизовані алгоритми лежать в основі різноманітних онлайн-активностей, запрограмовані на виконання цілого ряду дій, що варіюються від індексації вебсторінок для пошукових систем до виконання повторюваних завдань.

У цій статті розглянемо, що таке бот-трафік, які бувають боти, як виявити шкідливий трафік ботів на сайті та зупинити його через блокування різними способами.

Що таке бот-трафік?

Бот-трафік – це активність на вебсайті або онлайн-платформі, що генерується ботами. Відвідування вебсайтів ботами неминучі, незалежно від того, чи це велика онлайн-платформа зі значним трафіком, чи нещодавно запущений стартап.

Кожен бот, який отримує доступ до вебсайту, збільшує його навантаження, що при надмірній активності може мати негативні наслідки для коректного функціонування сайту та серверу, з якого той працює. Невибіркове споживання ресурсів неминуче призводить до уповільнення роботи вебсайтів, незалежно від їхнього розміщення.

Важливо відзначити! Не всі боти на вашому сайті є шкідливими!

Ботів можна умовно розділити на два типи: корисні боти (або їх ще називають “білі” боти) та шкідливі боти (зловмисні боти).

Корисні боти розробляються з дотриманням етичних принципів та норм, гарантуючи, що їхня діяльність не завдає шкоди користувачам та не порушує їхню конфіденційність. Зазвичай правила для коректної роботи бота визначаються у файлі robots.txt вебсайту. Корисний бот повинен спочатку перевіряти цей файл та, дотримуючись вказаних правил, виконувати запрограмовані дії.

Типи корисних ботів

Існує безліч типів корисних ботів, кожен з яких має своє призначення:

1. Боти пошукових систем – це боти, що сканують вебвміст, щоб індексувати інформацію для пошукових систем, роблячи її доступною для користувачів. Сюди можна віднести Googlebot, Baiduspider, Bingbot та інші.

Важливо зауважити! Іноді цим ботам немає сенсу сканувати ваш вебсайт. Наприклад, якщо ви не обслуговуєте китайський чи російський ринки, Baiduspider і YandexBot не повинні сканувати ваш сайт, адже це призведе до підвищеного навантаження на сервер.

2. Боти-агрегатори призначені для автоматичного збору інформації з різних джерел з метою створення повних каталогів або списків вмісту відповідно до вподобань своїх користувачів. Прикладом може слугувати бот Feedly Fetcher.

3. Боти бізнес-аналітики – боти, що аналізують відгуки про продукти, коментарі в соціальних мережах та інші дані, надаючи компаніям цінну інформацію про сприйняття бренду та поведінку клієнтів.

4. Боти для моніторингу сайту використовуються як інструмент для відстеження коректності функціонування вебсайту та сервера в цілому. Цей тип ботів постійно перевіряє стан сайту, зокрема доступність, швидкість завантаження та функціональність. Завдяки цьому вони можуть виявити проблеми, які можуть вплинути на відвідувачів, наприклад, повільний час завантаження, неробочі посилання або помилки сервера. Після виявлення проблеми бот надсилає сповіщення, тож власник сайту може швидко її вирішити й тим самим підтримати його безперебійну роботу. Деякі приклади цих ботів: Uptime Robot, StatusCake та Pingdom.

5. Чат-боти – це програми, які можуть імітувати розмову з людьми. Вони використовуються для автоматизації повторюваних завдань, таких як відповіді на запитання в чатах. Чат-боти працюють за допомогою заздалегідь визначених відповідей на конкретні тригери. Багато з них вже використовують штучний інтелект (ШІ) для більш природної розмови, кращого розуміння запитів та виконання складних завдань.

Типи шкідливих ботів

На противагу корисним ботам, шкідливі боти – це програмні агенти, що використовуються для різноманітних зловмисних цілей, таких як поширення спаму, крадіжка конфіденційних даних, атаки на вебсайти та інші види кіберзлочинності.

Наслідки шкідливих ботів для вебсайтів можуть бути серйозними. Вони можуть спричинити зниження швидкості роботи сайту, порушення його функціональності, крадіжку конфіденційної інформації, розповсюдження вірусів та інших шкідливих програм, а також вплинути на репутацію сайту в очах пошукових систем. Таким чином, ці зловмисні програми, подібно до своїх корисних аналогів, здатні виконувати автоматизовані дії, але з ворожою метою.

Ось деякі з поширених типів шкідливих ботів:

- Спам-боти – розсилають небажану пошту, рекламу та інші нав’язливі повідомлення. Спам-боти використовуються для зловмисних цілей, таких як фішинг, розповсюдження зловмисного програмного забезпечення або просування спам-продуктів чи послуг.

- DDoS-боти – переповнюють сервер вебсайту дуже великою кількістю трафіку, через що він стає недоступним для легітимних користувачів. Це може призвести до простою, втрати прибутку та шкоди репутації вебсайту.

- Боти-сканери – боти, що переглядають вебсторінки за гіперпосиланнями з метою отримання та індексування вебвмісту. Шкідливі сканери також сканують вебсайт на наявність вмісту, але не з наміром індексувати його, а щоб скопіювати його вміст та контент.

- Боти-скрапери – це боти, які зчитують дані з вебсайтів, щоб зберегти їх у автономному режимі та дозволити їх повторне використання. Це може мати форму копіювання всього вмісту вебсторінок або копіювання вебвмісту для отримання певних точок даних, таких як назви та ціни продуктів на сайтах електронної комерції.

Збирання та аналіз вмісту вебсайтів — це сіра зона. У деяких випадках зчитування є законним і може бути дозволене власниками вебсайтів. В інших випадках оператори ботів можуть порушувати умови використання вебсайту або, що ще гірше, використовувати сканування для викрадення конфіденційного чи захищеного авторським правом вмісту.

Шкідливі боти створюються з наміром завдати шкоди, використати вразливості або порушити роботу сервісів.

З іншого боку, навіть нешкідливі боти, розроблені для законних цілей, таких як індексація пошукових систем, моніторинг вебсайтів або обслуговування клієнтів, можуть ненавмисно створювати надмірне навантаження на сервери. Наприклад, якщо пошуковий бот надто агресивно сканує вебсайт, він може споживати велику кількість пропускної здатності та серверних ресурсів, що впливає на продуктивність вебсайту для законних користувачів.

Загальні ознаки шкідливого трафіку ботів

Ознаки того, що ваш вебсайт атакований ботами:

- Раптові стрибки трафіку.

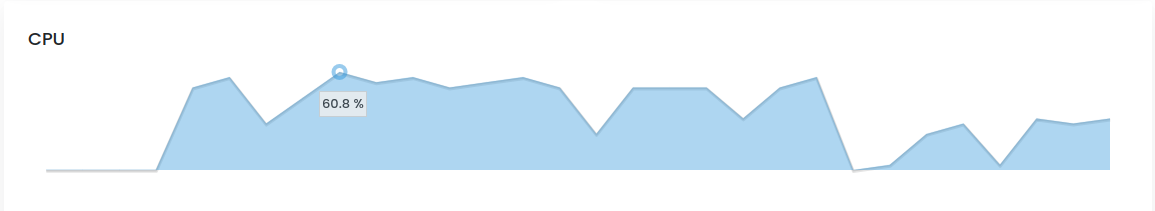

Боти, як правило, з’являються масово, особливо для сканування та DDoS-атак, тобто ви побачите раптовий незрозумілий сплеск переглядів сторінок. - Проблеми з продуктивністю сервера.

Оскільки боти з’являються у таких великих обсягах, ваші сервери можуть не впоратися з додатковим навантаженням, що сповільнить роботу вебсайту для всіх користувачів. Щойно ви додасте більше ресурсів сервера, більше ботів зможуть проникнути, загостривши проблему. - Високий показник відмов.

Оскільки боти запрограмовані на виконання певної дії, досягнувши своєї мети (наприклад, просканувавши сторінку сайту), боти покидають ваш сайт. Це може виглядати так, наче значна частина відвідувачів сайту покидає його одразу після перегляду головної сторінки. Подібна активність приводить до штучно завищеного показника відмов, оскільки боти більше ніяк не взаємодіють з сайтом. - Ненормальна тривалість сеансу.

Люди, як правило, залишаються на вебсайті принаймні кілька секунд, але не довше кількох хвилин на одній сторінці. Тривалість сеансу в декілька хвилин може вказувати на трафік бота.

Як зупинити трафік ботів?

Не існує єдиного рішення, яке б могло повністю вирішити ситуацію з ботами для усіх сайтів.

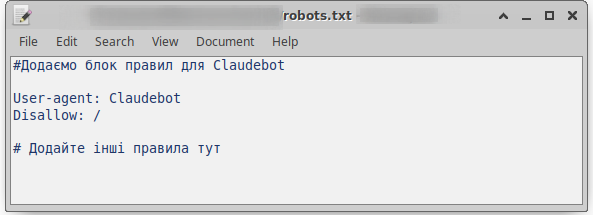

Файл robots.txt – збірник наших правил для ботів

Файл robots.txt – це першочерговий вказівник по сайту для ботів. Він визначає, які частини вашого сайту можуть бути проскановані ботами, а які – ні. Це важливий інструмент для контролю доступу до вебресурсу і підтримки оптимальної видимості в пошукових системах.

Як працює файл robots.txt?

Пошукові боти переміщуються в інтернеті розгалуженою мережею посилань, сторінок і вебсайтів, старанно вивчаючи кожне посилання, на яке натрапляють.

Однак, натрапивши на файл robots.txt на сайті, бот пріоритетно читає його, перш ніж продовжити сканування. Цей файл, по суті, діє як набір інструкцій, вказуючи боту, які області сайту відкриті для вивчення, а які слід виключити з процесу індексування.

Синтаксис robots.txt

Файл robots.txt складається з одного або декількох блоків, які описують кожне правило. Кожен блок складається з двох рядків:

- Визначення «User-agent» – рядок визначає конкретний вебсканер, до якого застосовуються наступні правила.

- Інструкція або правило (заборона або дозвіл на виконання дій).

Простий блок може мати такий вигляд:

User-agent: Claudebot

Disallow: /Пояснення блоку:

- User-agent: Claudebot – це означає, що цей конкретний рядок інструкцій призначений для бота з назвою “Claudebot”.

- Disallow: / – цей рядок забороняє Claudebot індексувати головну сторінку вашого сайту та будь-які підсторінки на тому ж рівні.

Важливо!

Використання символу «*» у рядку «User-agent:» із наступною директивою «Disallow: /» встановлює правило заборони сканування всього вашого сайту усіма ботами:

User-agent: *

Disallow: /Це може призвести до того, що ваш сайт стане невидимим у результатах пошуку, хоча даний спосіб заборони індексації сайту може бути використано при розробці нового проекту.

Якщо ви, навпаки, хочете дозволити всім пошуковим системам сканувати весь ваш сайт, ваш блок правил виглядатиме так:

User-agent: *

Allow: /Пояснення блоку:

- User-agent: * – рядок вказує, що правило стосується всіх ботів, які відвідують ваш сайт.

- Allow: / – правило, що дозволяє індексувати усі сторінки сайту.

Правила заборони та дозволу сканування ботами вебсайтів можна поєднувати. Файл robots.txt дозволяє вам чітко контролювати, які частини вашого сайту можуть сканувати та індексувати пошукові системи.

Ви можете використовувати комбінацію правил Disallow та Allow для створення більш детальних правил сканування. Наприклад, можна заблокувати доступ ботів до всього сайту, а потім дозволити їм сканувати лише кілька сторінок:

User-agent: *

Disallow: /

Allow: /index.html

Allow: /about-us.html

Allow: /contact-us.htmlТобто, правило «Allow» дозволяє пошуковим системам сканувати підкаталог або певну сторінку, навіть у каталозі, який раніше було заборонено сканувати.

Важливо! Для встановлення правил для кожного бота потрібно окремо створювати новий блок.

User-agent: BaiduBot

Disallow: /

Disallow: /admin/

User-agent: Claudebot

Disallow: /

User-agent: PetalBot

Disallow: /Обмеження частоти сканування вебсайту

Правило Crawl-Delay дозволяє встановити затримку сканування для уникнення надмірного навантаження на сервер та уповільнення роботи вебсайту.

Наприклад, потрібно встановити правило, аби усі боти чекали 20 секунд після кожної дії сканування. Встановити затримку на 20 секунд можна наступним чином:

User-agent: *

Crawl-delay: 20ВАЖЛИВО ВІДЗНАЧИТИ! Хоча правило Crawl-delay може бути включено в файли robots.txt, це НЕ гарантований спосіб контролювати частоту сканування вашого сайту, оскільки деякі боти можуть його ігнорувати. Наприклад, для Google це правило є застарілим. Якщо ви хочете встановити швидкість сканування для Googlebot, вам потрібно буде зробити це в Search Console.

Як створити robots.txt?

Файл robots.txt завжди має бути на рівні кореневого домену, тобто розміщуватися в кореневій директорії сайту. Для домену example.com файл robots.txt знаходиться за адресою example.com/robots.txt. Якщо його буде розмішено в іншому місці, сканери будуть ігнорувати прописані правила, оскільки не знаходитимуть цього файлу.

Отже, створюємо текстовий файл robots.txt в кореневій директорії нашого сайту. Для цього відкрийте текстовий редактор. Ви можете використовувати будь-який текстовий редактор, наприклад Блокнот, TextEdit або Vim.

Введіть наступні рядки:

User-agent: *

Disallow: /

Sitemap: https://www.example.com/sitemap.xml

# Інші правила додайте тутПояснення блоку:

- User-agent: * – вказує, що ці правила застосовуються до всіх вебсканерів.

- Disallow: / – вказує, що всі сторінки в кореневому каталозі вашого вебсайту (наприклад, https://example.com/) не повинні індексуватися.

- Sitemap: https://www.example.com/sitemap.xml – вказує пошуковим системам на розташування вашої карти сайту. Карта сайту – це список усіх сторінок на вашому вебсайті.

Збережіть файл як robots.txt. Переконайтеся, що ви зберегли файл із суфіксом .txt.

Завантажте файл robots.txt до кореневого каталогу вашого вебсайту. Кореневий каталог – це місце, де знаходиться головна сторінка вашого вебсайту. Зазвичай ви можете завантажити файли на свій вебхостинг за допомогою FTP або файлового менеджера.

На жаль, боти сприймають файл robots.txt лише як рекомендацію. Деякі боти ігноруються robots.txt та продовжують сканувати вебсайт. Описані вище кроки можуть бути неефективними для відсіювання шкідливих ботів та цілеспрямованих атак.

Блокування окремих IP-адрес

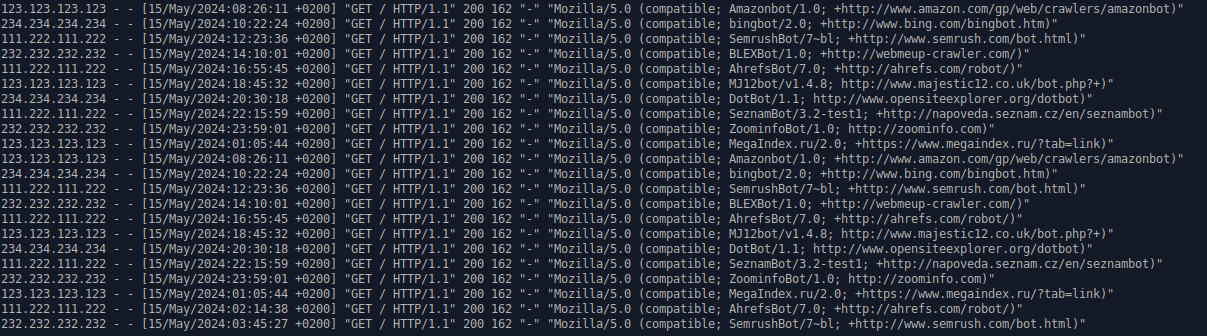

Якщо ви стикаєтеся зі зловмисною активністю або надмірними запитами з певних IP-адрес від ботів, ви можете розглянути можливість їх блокування за окремими IP-адресами.

Ви можете використовувати декілька методів для їх блокування.

Використання брандмауера (фаєрвола)

Брандмауер – це програмне забезпечення, яке контролює та фільтрує мережевий трафік, що надходить до вашого вебсайту.

Брандмауер діє як бар’єр між вашим вебсайтом та інтернетом. Він аналізує кожен пакет даних, який надходить до вашого сайту, і вирішує, дозволити його чи заблокувати.

Важливо!

- перш ніж блокувати будь-які IP-адреси, переконайтеся, що ви правильно ідентифікували їх як джерело зловмисної активності;

- блокування легітимних IP-адрес може призвести до проблем із доступом для ваших користувачів;

- завжди робіть резервні копії своїх даних та налаштувань, перш ніж вносити будь-які зміни до конфігурації.

Використання брандмауера CSF на Shared-хостингу в HostPro

CSF (ConfigServer Security & Firewall) – це потужний брандмауер для серверів Linux, який забезпечує високу безпеку та зручне управління. На shared-хостингу в HostPro, де CSF встановлений за замовчуванням, він допомагає захищати сайти від різних шкідливих дій, таких як DDoS-атаки, спроби злому і шкідливі боти.

Основні функції CSF:

- фільтрація трафіку: CSF фільтрує вхідний та вихідний трафік, дозволяючи тільки легітимний;

- блокування IP: автоматичне блокування IP-адрес, які виявляються шкідливими;

- обмеження доступу: можливість встановлення правил для доступу до серверу;

- логування: ведення логів для аналізу атак і виявлення загроз.

Важливо! Блокування IP-адрес через CSF на shared-хостингу HostPro можливо лише через звернення до технічної підтримки.

Використання брандмауера на VPS в HostPro

Для VPS-хостингу в HostPro, брандмауер можна як активувати разом із встановленням панелі управління, так і виконати налаштування без панелі керування.

Багато панелей керування, таких як cPanel, Plesk, CWP або CyberPanel, мають вбудовані брандмауери як додаткове програмне забезпечення. cPanel та CWP використовують CSF як вбудований брандмауер, а CyberPanel – Fail2ban.

Також ви можете встановити та налаштувати брандмауер на VPS без використання панелі керування, однак цей метод є складнішим і потребує знань командного рядка.

Блокування ботів за допомогою .htaccess

Файл .htaccess – це конфігураційний файл, який використовується для керування різними аспектами функціонування вебсайту. Він дозволяє розробникам та адміністраторам серверів змінювати «поведінку» сервера для певних каталогів або URL-адрес без внесення змін до основного конфігураційного файлу вебсервера.

Ви можете використовувати .htaccess для блокування доступу до вашого вебсайту з певних IP-адрес. Цей метод блокування може бути доволі ефективним захистом від шкідливих ботів.

Важливо зазначити! Внесення неправильних змін до файлу .htaccess може призвести до проблем з роботою вашого вебсайту. Тому рекомендується створювати резервні копії файлів .htaccess перед внесенням будь-яких змін. Далі розповімо про кілька кроків, як можна заблокувати ботів за допомогою .htaccess.

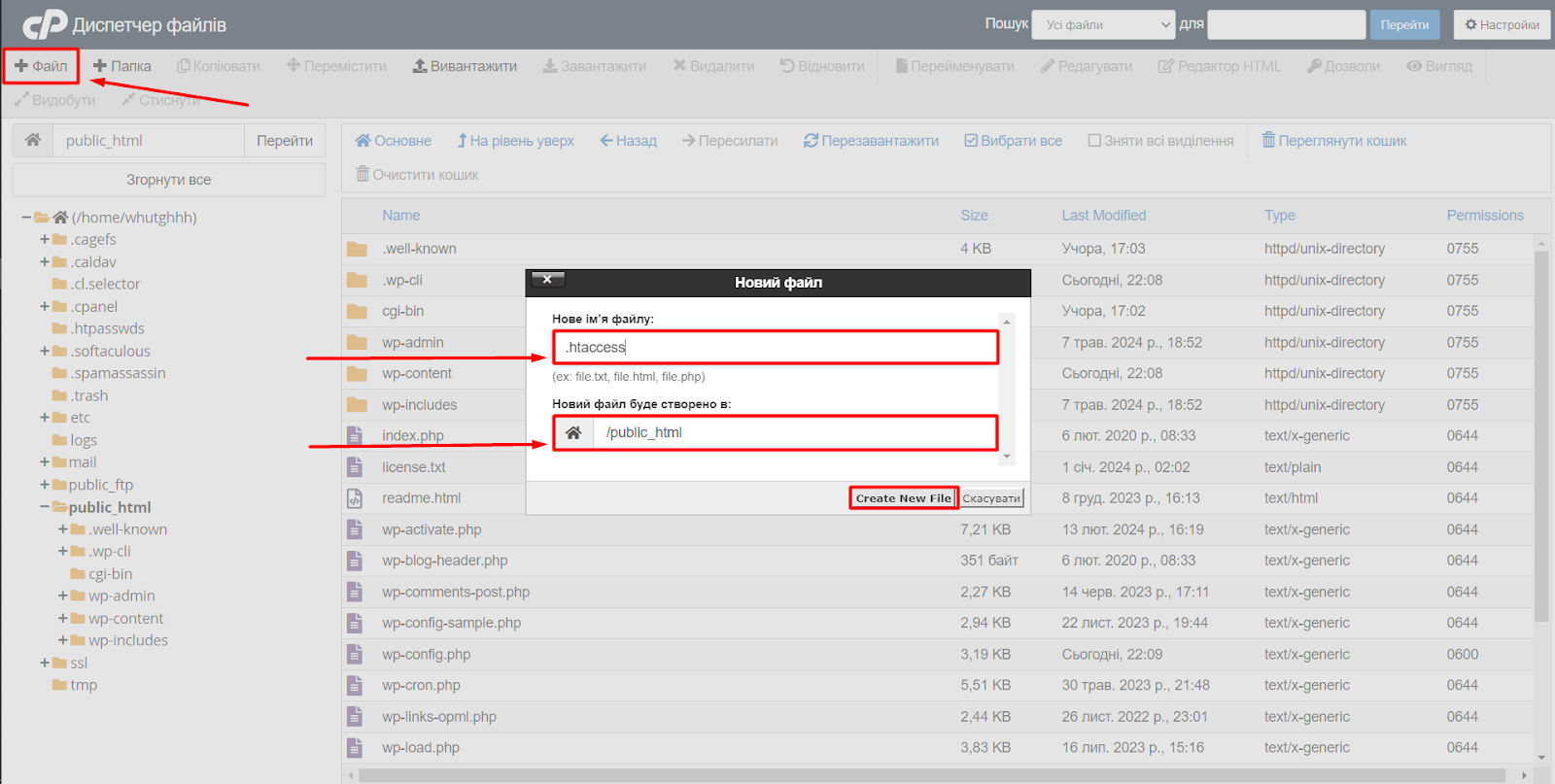

Створіть файл .htaccess

Якщо у вашій кореневій папці сайту немає файлу .htaccess, створіть його. Для створення файлу .htaccess підійде як локальний текстовий редактор, так і диспетчер файлів панелі керування.

Примітка!

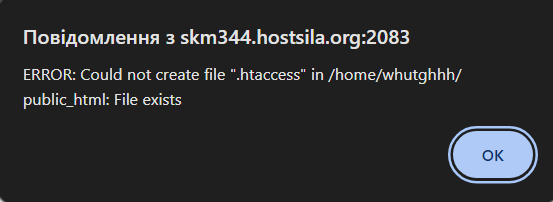

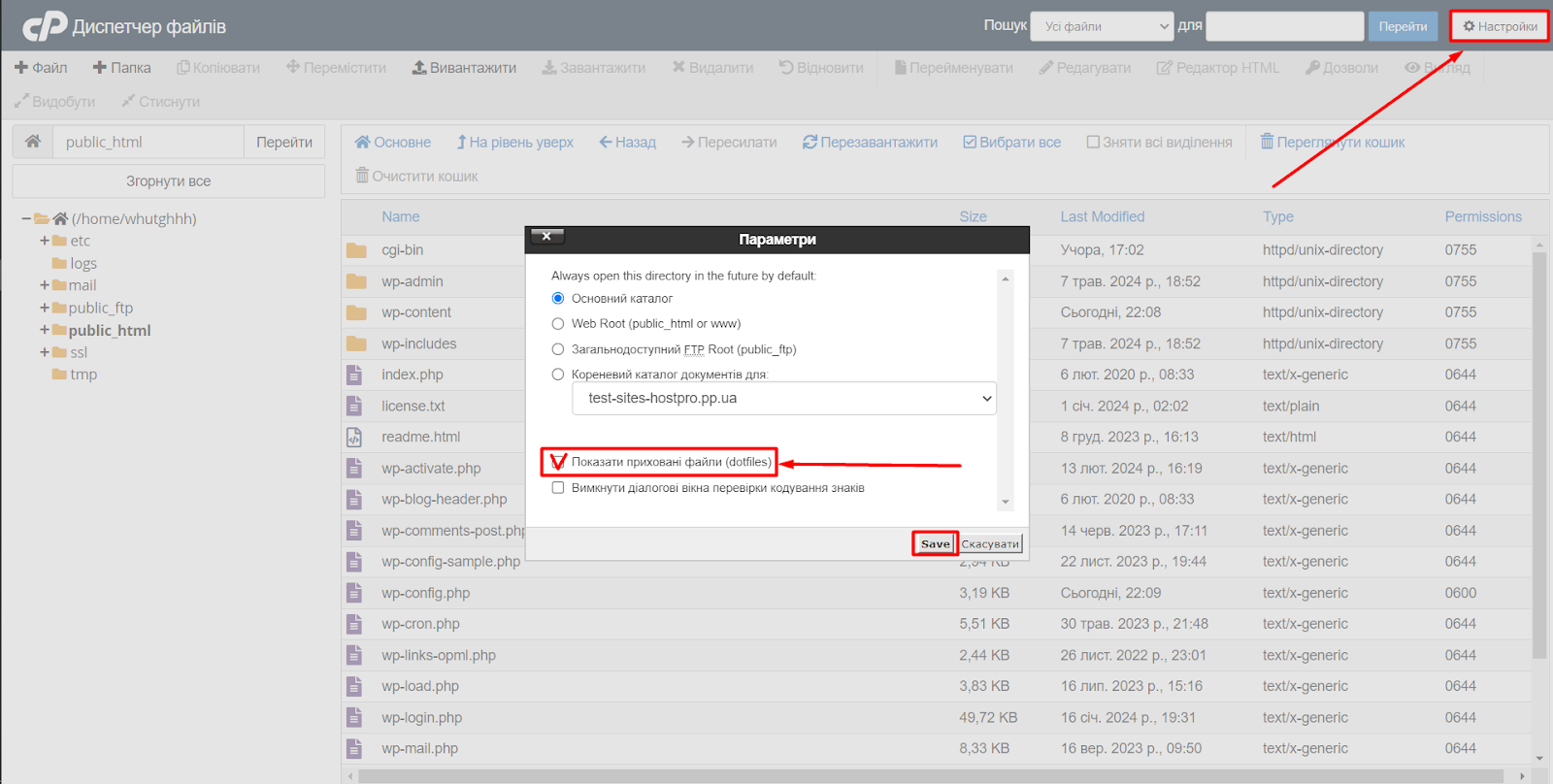

Ви можете зіткнутися з ситуацією, коли в переліку файлів сайту не буде відображатися файл .htaccess, але при його створенні виникне помилка. ERROR: Could not create file “.htaccess” in /home/whutghhh/public_html: File exists.

Деякі файли, включаючи .htaccess, за замовчуванням приховані, щоб не захаращувати список файлів і уникнути їх випадкового видалення. Це поширена практика на вебсерверах, адже .htaccess містить важливі налаштування, які можуть призвести до проблем, якщо їх змінити випадково.

Щоб знайти прихований .htaccess, вам потрібно увімкнути опцію відображення прихованих файлів у вашому файловому менеджері.

Додайте правило блокування

Відкрийте файл .htaccess і додайте до нього наступний код:

# Блокування по IP-адресі

Order allow,deny

Deny from 192.168.1.100

Deny from 192.168.1.101Дане правило означає, що наведені IP-адреси заблоковані і не зможуть отримати доступ до вашого вебсайту.

Важливо! Додавши в кінці даного правила рядок «Allow from all», ви дозволите доступ до вебсайту з усіх інших IP-адрес. Оскільки «Allow from all» розміщено після директиви «Deny», дане правило фактично дозволяє відвідувати сайт усім IP, окрім IP-адреси, явно забороненої в попередньому рядку.

Також блокування шкідливих ботів можна виконувати через блокування агентів користувача.

Для цього у файл .htaccess додайте нове правило:

# Блокування за агентом користувача

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} UserAgentName [NC]

RewriteRule .* - [F,L]Дане правило є шаблоном, у якому замість «UserAgentName» необхідно вказати конкретного агента користувача. Наприклад:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ClaudBot [NC]

RewriteRule .* - [F,L]Пояснення по рядкам:

- RewriteEngine On

Цей рядок активує модуль перенаправлення запитів Apache, який необхідний для роботи наступних правил. - RewriteCond %{HTTP_USER_AGENT} ClaudBot [NC]

Використовується для перевірки рядка User-Agent у заголовку HTTP-запиту. Якщо рядок User-Agent містить слово «ClaudBot» (в нечутливому до регістру режимі), умова буде вважатися істинною. - RewriteRule . – [F,L]*

Цей рядок правила визначає, що робити, якщо умова RewriteCond буде істинною. В даному випадку символ «.» використовується як підстанова, яка відповідає будь-якій URL-адресі на вашому вебсайті. «- [F,L]» вказує, що запит слід негайно завершити з кодом помилки 403 (Заборонено) і не обробляти його далі.

У наступному прикладі правила ви можете бачити, як можна розширити цю логіку, щоб блокувати декількох ботів одночасно. Просто додайте додаткові умови RewriteCond, розділені “|” (бічний слеш), щоб охопити всіх ботів, яких ви хочете заблокувати. Наприклад:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (SCspider|Textbot|s2bot).*$ [NC]

RewriteRule .* - [F,L]Цей код блокуватиме ботів з іменами “SCspider”, “Textbot” та “s2bot”. Ви можете додати скільки завгодно умов RewriteCond, розділених “|”, щоб охопити ширший спектр ботів.

Збережіть файл .htaccess

Збережіть файл .htaccess у кореневій папці вашого сайту.

Пам’ятайте, що важливо регулярно оновлювати список IP-адрес та агентів користувачів ботів, щоб блокування залишалося ефективним.

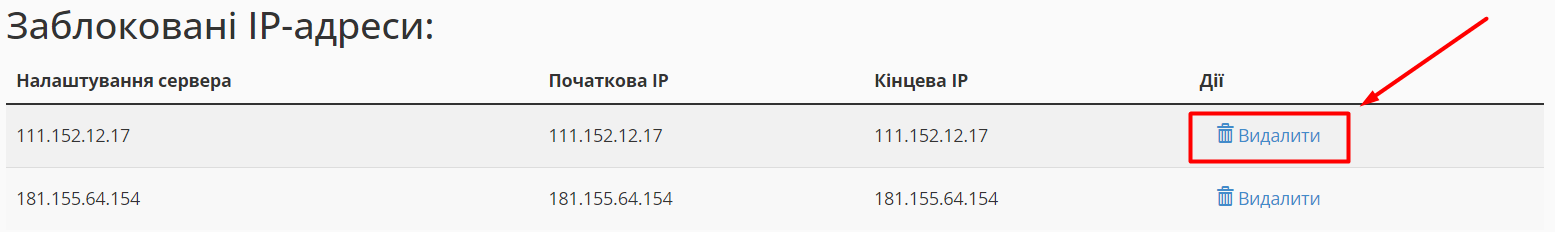

Блокування IP через панель керування cPanel

Для блокування IP адрес cPanel надає можливість використовувати власний інструмент – IP Blocker (Блокувальник IP-адрес).

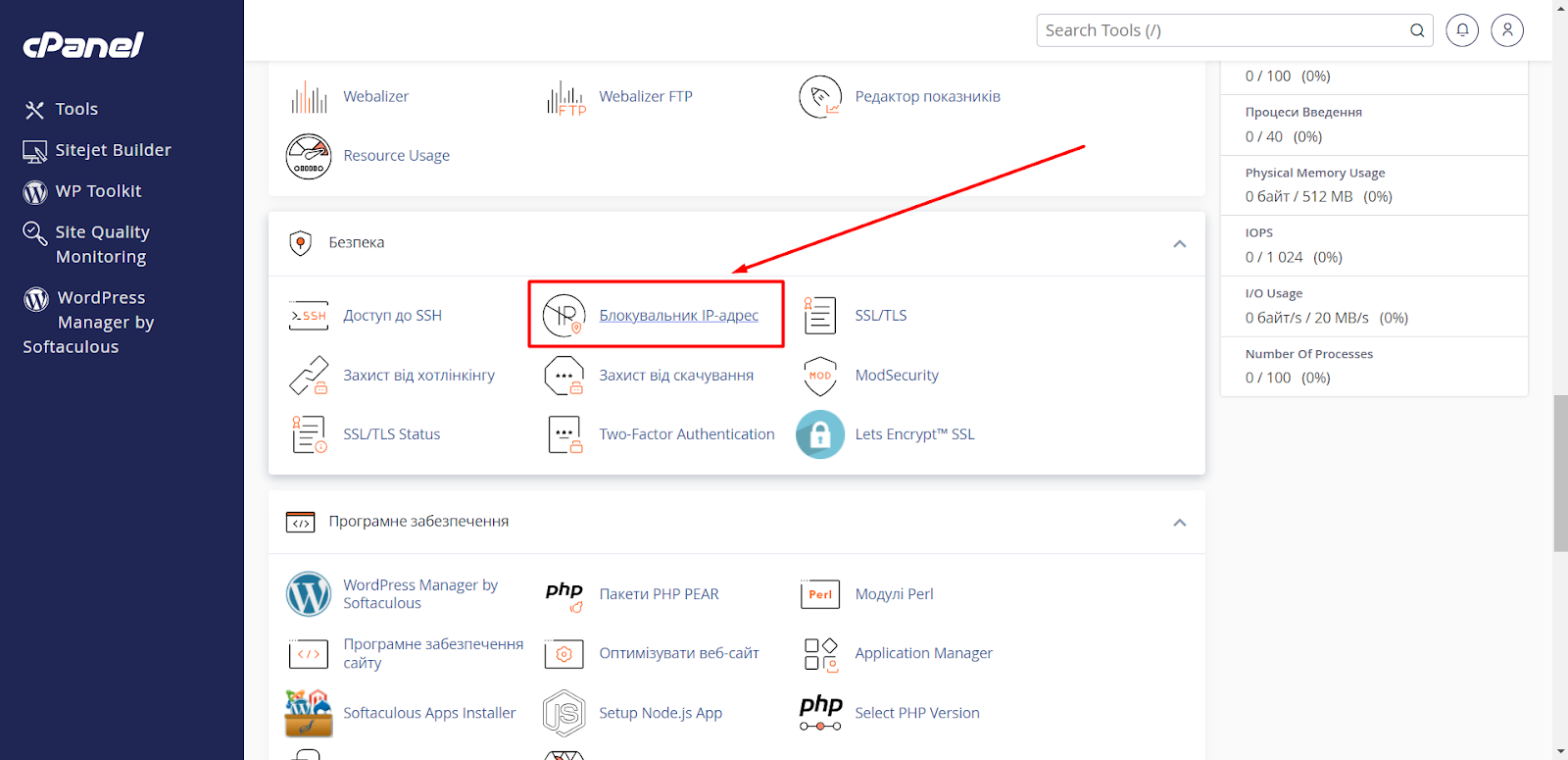

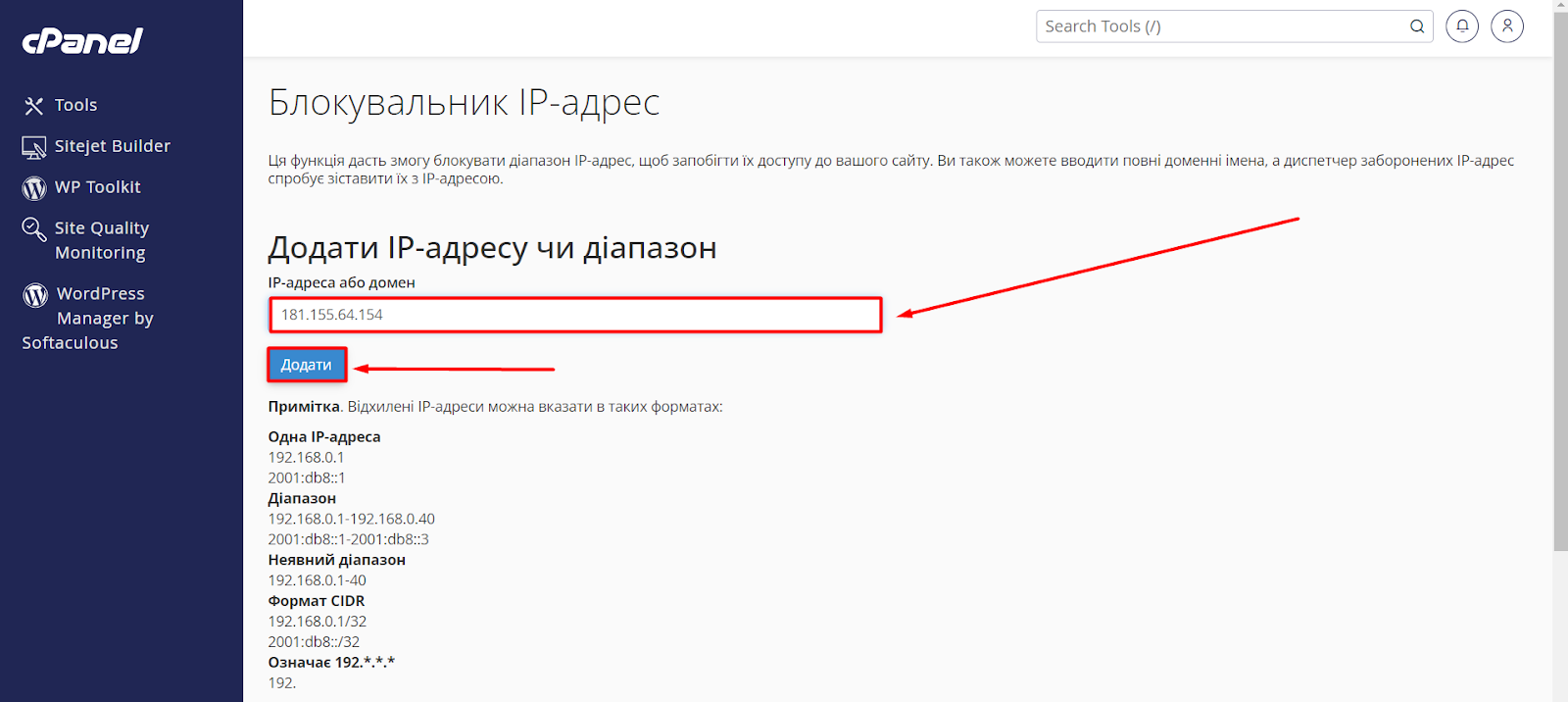

Щоб заблокувати IP-адресу, виконайте наступні кроки:

1. Увійдіть у свою панель керування cPanel та перейдіть до розділу «Безпека» ⇨ меню «Блокувальник IP».

2. Введіть IP-адресу, яку потрібно заблокувати, у поле IP-адреса або домен і натисніть кнопку «Додати».

Його буде додано до списку заблокованих IP-адрес.

Важливо! Даний метод блокування є аналогом до ручного блокування через файл .htaccess, адже після блокування IP адреси через панель керування, система автоматично додає адреси до вашого .htaccess файлу.

Розблокувати IP-адресу

Ви завжди можете розблокувати IP-адресу, натиснувши «Видалити» поруч із відповідною IP-адресою.

Блокування шкідливих ботів в конфігураційних файлах

Блокування ботів в конфігураційних файлах – це один з найкращих способів захистити ваш вебсайт від шкідливої активності. Блокування ботів може здійснюється на рівні віртуальних хостів (vhosts). Це означає, що ви можете створити окремі правила блокування для кожного сайту на вашому сервері.

Важливо! Блокування шкідливих ботів у конфігураційних файлах може бути застосоване виключно для послуг VPS або для виділених серверів.

Метод 1. Створення файлу з правилами блокування

Ви можете створити окремий файл, який буде містити правила блокування шкідливих ботів, які будуть діяти для усіх ваших вебсайтів, які розміщені на вашому сервері. Для цього слід виконати декілька кроків:

- Створіть каталог includes (якщо його ще немає) за шляхом /etc/nginx/:

- Створіть файл, який буде містити правила блокування ботів. Ви можете назвати його як завгодно. Наприклад – block_bots.conf.

Важливо! Назва файлу тут не грає важливої ролі, головне – даний файл повинен мати розширення .conf. - У файлі /etc/nginx/includes/block_bots.conf пропишіть правила блокування необхідного вам списку ботів.

Приклад правила для блокування шкідливих ботів:

if ($http_user_agent ~* Amazonbot|Claudebot|SeopultContentAnalyzer|SeekportBot|DataForSeoBot|Barkrowler|BLEXBot|SemrushBot|MJ12bot|AhrefsBot|bingbot|DotBot|PetalBot|LinkpadBot|SputnikBot|statdom. ru|MegaIndex.ru|WebDataStats|Jooblebot|Baiduspider|BackupLand|NetcraftSurveyAgent|openstat.ru) {

return 444;

}Пояснення правила:

- if ($http_user_agent ~* … ) – цей рядок перевіряє, чи заголовок User-Agent у запиті містить будь-яке з перелічених імен ботів (розділені |). Модифікатор ~* вказує на відповідність регулярного виразу (будь-яка частина рядка User-Agent може містити ім’я бота).

- Amazonbot|Claudebot|… – це список назв ботів, які потрібно блокувати.

- return 444; – це умова, за якою, якщо знайдено відповідний User-Agent, Nginx поверне код стану 444. Це спеціальний код, який ви можете визначити у своєму блоці сервера для обробки заблокованих запитів. Ви можете вибрати будь-який код між 400 (Поганий запит) і 500 (Внутрішня помилка сервера) для цієї мети.

Важливо! Цей код є лише прикладом. Вам потрібно буде його змінити відповідно до ваших потреб.

4. Включення правил блокування в конфігураційні файли vhosts.

У кожному файлі vhost сайту вкажіть рядок:

include /etc/nginx/includes/block_bots.conf;Таким чином ви «підключите» задані вами правила блокування. Вийдіть і збережіть файл конфігурації, а щоб зміни набули чинності, перезавантажте вебсервер nginx. Переконайтеся, що ваша конфігурація nginx виглядає коректно, виконавши команду:

nginx -tЯкщо помилки не виявлено, ви можете перезавантажити свою конфігурацію за допомогою такої команди:

service nginx reload или systemctl reload nginx(довший варіант, оновлення лише конфігураційних файлів, швидкість оновлення залежить від кількості конфігураційних файлів)

або

service nginx restart(швидший варіант, але декілька секунд сайт може не працювати)

Перевага використання загального файлу з правилами полягає в тому, що вам не потрібно буде редагувати кожен конфігураційний файл сайту окремо при внесенні змін до списку заблокованих ботів. Ви просто оновлюєте файл /etc/nginx/includes/block_bots.conf, і зміни застосовуються до всіх сайтів, де використовується цей інклюд. Ви також можете створювати різні файли інклюдів з правилами блокування для різних груп сайтів.

Метод 2. Додавання правила блокування в конфігураційний файл сайту

Цей метод дозволяє заблокувати доступ до вашого сайту шкідливим ботам безпосередньо в конфігураційному файлі вашого сайту. Не рекомендується для початківців, оскільки може призвести до проблем з вашим сайтом, якщо його налаштувати неправильно.

Для того, щоб заблокувати шкідливих ботів за допомогою конфігураційного файлу вашого сайту, ви можете виконати наступні кроки:

1. Відкрийте конфігураційний файл вашого сайту.

Вам потрібно знайти файл vhost для вашого сайту. Цей файл зазвичай знаходиться в папці /etc/nginx/sites-available/ (для Nginx) або /etc/apache2/sites-available/ (для Apache).

2. Додайте правило блокування до файлу.

Додайте наступний рядок до блоку server вашого сайту:

if ($http_user_agent ~* Amazonbot|Claudebot|SeopultContentAnalyzer|SeekportBot|DataForSeoBot|Barkrowler|BLEXBot|SemrushBot|MJ12bot|AhrefsBot|bingbot|DotBot|PetalBot|LinkpadBot|SputnikBot|statdom. ru|MegaIndex.ru|WebDataStats|Jooblebot|Baiduspider|BackupLand|NetcraftSurveyAgent|openstat.ru) {

return 444;

}3. Збережіть файл конфігурації.

4. Перезавантажте вебсервер.

Після виконання цих кроків шкідливий бот з User-Agent, який ви вказали, буде заблокований від доступу до вашого сайту.

Ці методи описують, як блокувати ботів на вебсервері Nginx. Якщо ви використовуєте інший вебсервер, як-от Apache, LiteSpeed або OpenLiteSpeed, принцип може бути схожий, але кроки налаштування будуть дещо іншими.

Перед використанням методу блокування ботів через конфігураційні файли рекомендується:

- створити резервну копію вашого конфігураційного файлу;

- ознайомитися з основами роботи з вебсерверами та конфігураційними файлами;

- звернутися за допомогою до досвідченого користувача або веброзробника, якщо ви не впевнені у своїх силах.

CloudFlare – як інструмент для боротьби зі шкідливим трафіком

CloudFlare – це сервіс, який допомагає покращити безпеку та продуктивність вашого сайту. Він працює як посередник між вашим сайтом та відвідувачами, фільтруючи трафік і забезпечуючи швидшу доставку контенту.

Щоб скористатися усіма перевагами CloudFlare, зокрема й блокуванням шкідливих ботів, необхідно попередньо підключити його до вашого вебсайту. CloudFlare пропонує декілька функцій, які можна використовувати для блокування ботів. Розглянемо деякі з них у безкоштовній версії CloudFlare.

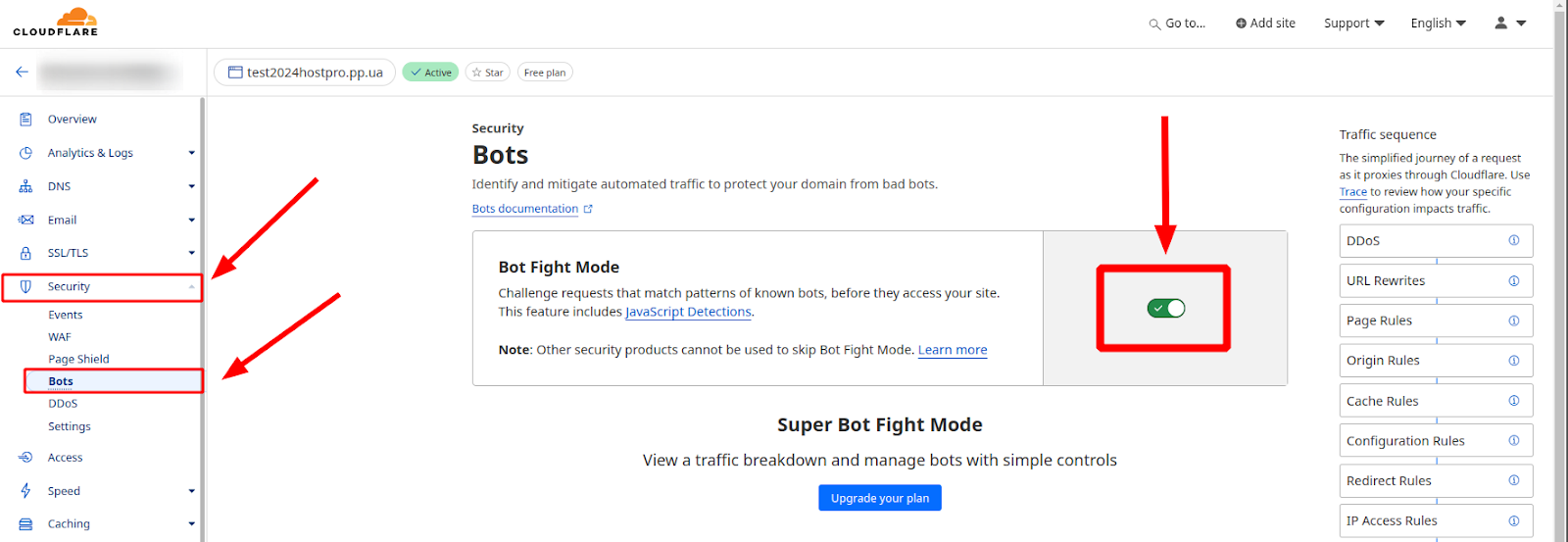

Режим Bot Fight Mode

CloudFlare Bot Fight Mode – це безкоштовна функція, яка допомагає ідентифікувати та блокувати шкідливих ботів на вашому вебсайті. Вона працює, аналізуючи трафік до вашого сайту та блокуючи запити, які вважаються підозрілими.

Як увімкнути Bot Fight Mode?

- Увійдіть до свого облікового запису CloudFlare.

- Виберіть домен, для якого потрібно ввімкнути Bot Fight Mode.

- Перейдіть до розділу «Безпека» ⇨ «Блокування ботів».

- Увімкніть перемикач «Bot Fight Mode».

Чи допоможе Bot Fight Mode у боротьбі зі шкідливими ботами?

Так, Bot Fight Mode може допомогти вам у боротьбі зі шкідливими ботами, але це не гарантує 100% захисту. Bot Fight Mode використовує простий набір правил для ідентифікації ботів, тому деякі складні боти можуть його оминути.

Для кращого захисту рекомендується використовувати Bot Fight Mode разом з іншими функціями безпеки CloudFlare.

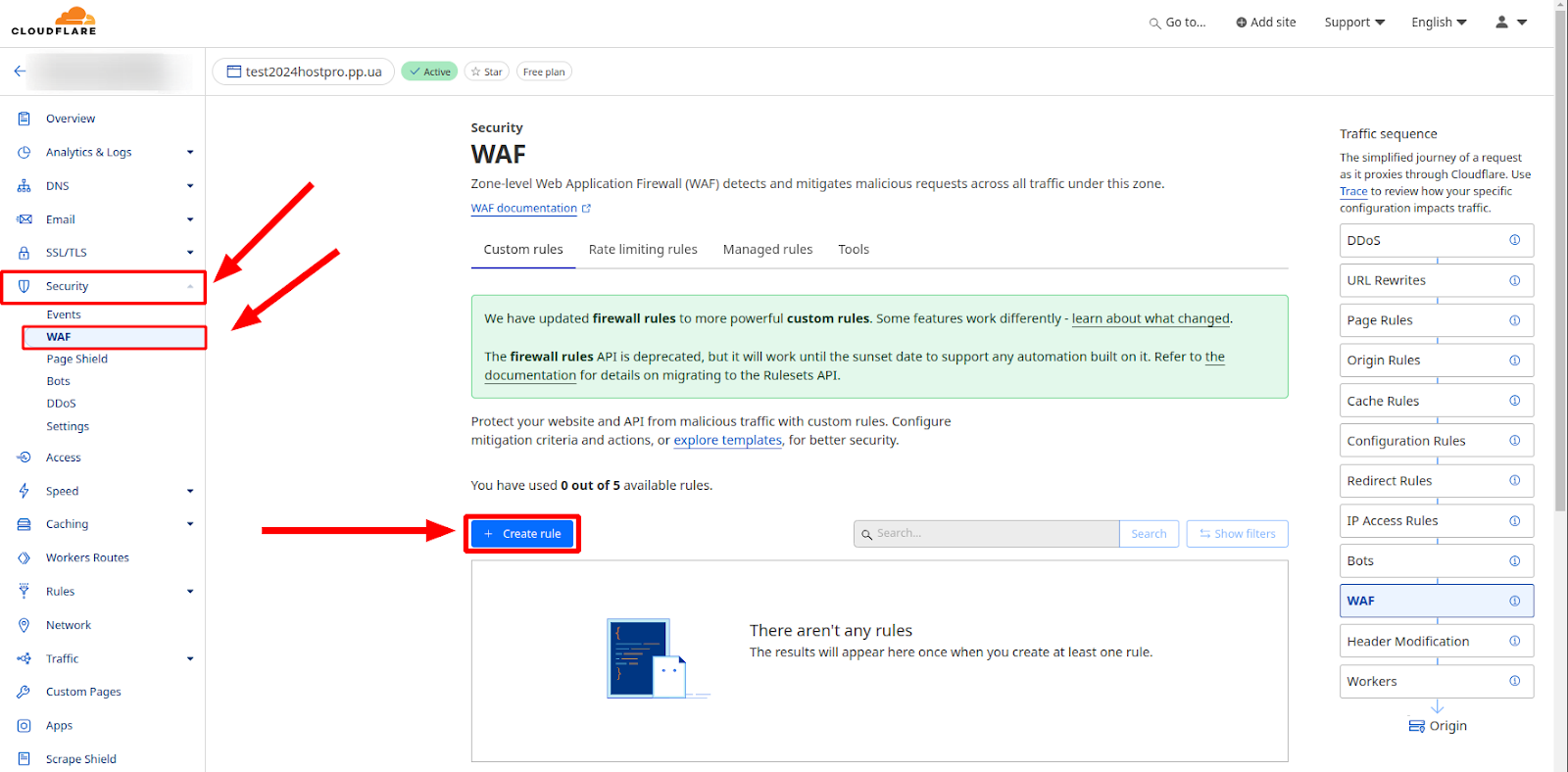

Брандмауер CloudFlare (WAF)

Налаштування правил брандмауера CloudFlare дає власнику вебсайту широкий спектр можливостей для точного контролю над тим, які HTTP-запити можуть їх досягати. Брандмауер CloudFlare є досить гнучкою та інтуїтивно зрозумілою системою, що дозволяє створювати та налаштовувати правила відповідно до ваших потреб, забезпечуючи максимальний захист та кращий контроль над доступом до вашого контенту.

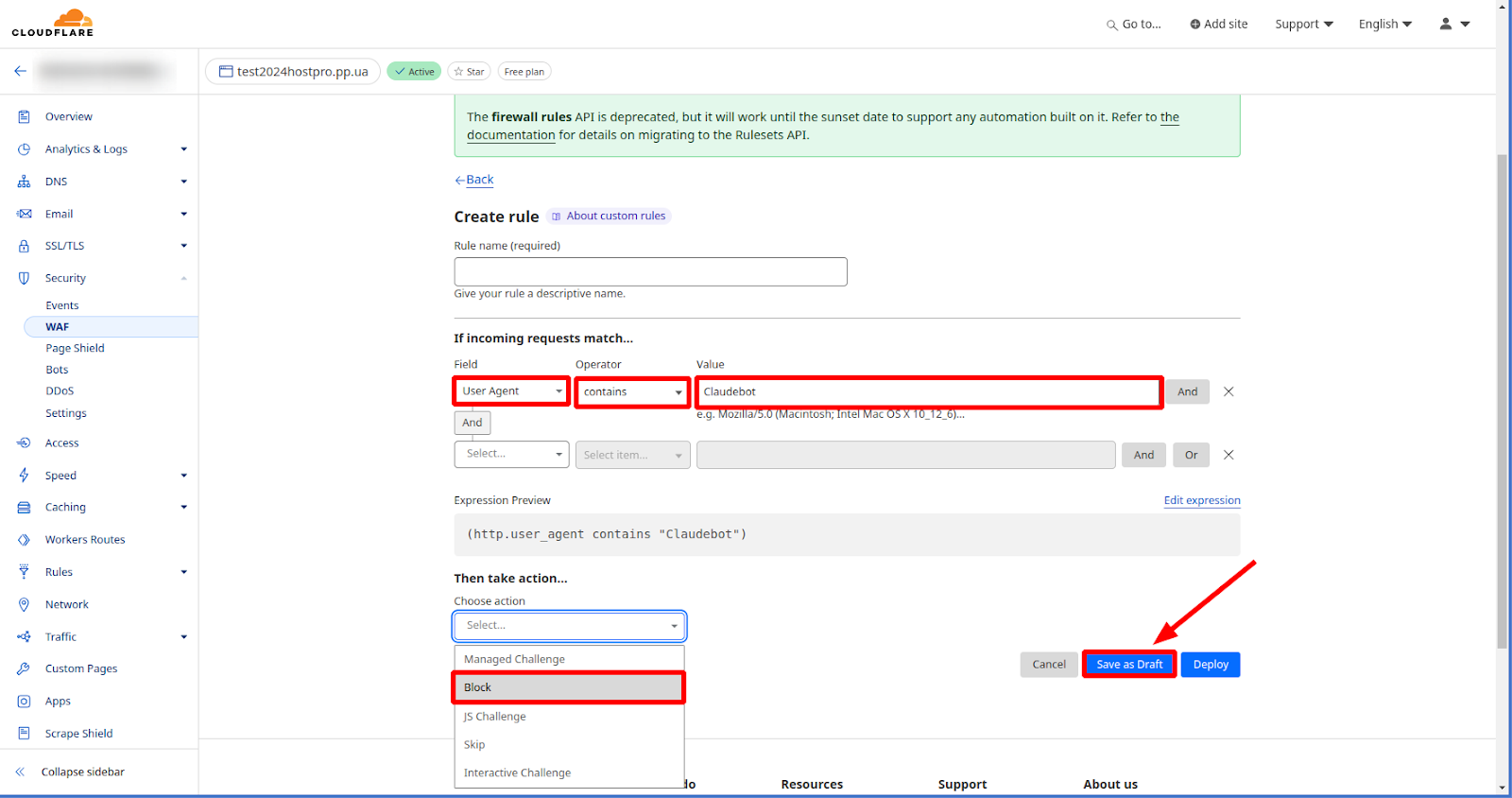

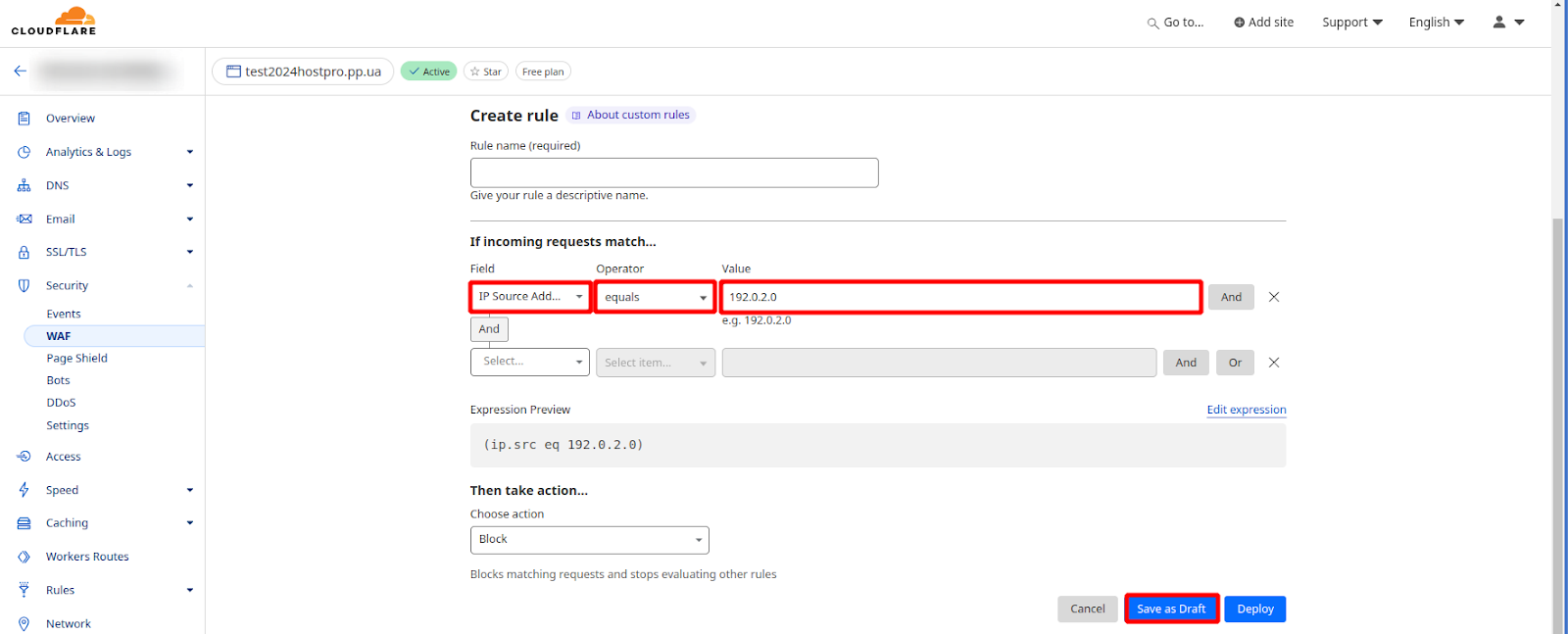

Блокування ботів за допомогою User Agent в Cloudflare WAF – це ще один ефективний спосіб захистити ваш вебсайт від шкідливого трафіку. Для цього потрібно виконати наступні кроки:

- Увійдіть до свого облікового запису Cloudflare.

- Перейдіть на сторінку WAF для свого домену у розділі «Безпека».

- Натисніть кнопку «Створити правило».

- Виберіть «User Agent» як тип правила.

- У полі «Оператор» виберіть позначку «contains».

- У поле «Значення» введіть User Agent, який ви хочете заблокувати.

- Виберіть, яка дія буде виконуватися, коли WAF виявить відповідний User Agent. Зазвичай вибирають «Блокувати».

- Натисніть кнопку «Зберегти».

Важливо! Для блокування окремих IP-адрес виконується аналогічна послідовність дій, лише як тип правила (пункт 4) обирається відповідно пункт «IP Source Address» та у полі значення вказується IP-адреса, яку потрібно заблокувати.

Блокування користувацьких агентів потребує обережного підходу. Регулярно аналізуйте журнали свого вебсайту та за необхідності коригуйте правила блокування. Це допоможе знайти оптимальний баланс між безпекою, продуктивністю та зручністю для користувачів.

На завершення

У комплексі всі описані методи створюють надійну систему захисту від шкідливих ботів, дозволяючи підтримувати стабільну роботу вебсайту та захищати його від потенційних загроз.

Але важливо пам’ятати, що надмірне блокування може призвести до небажаних наслідків, таких як обмеження доступу до сайту легітимним користувачам та пошуковим системам. Це може негативно вплинути на SEO і знизити відвідуваність ресурсу. Тому важливо збалансовано підходити до налаштування фільтрів та правил блокування, враховуючи можливі позитивні та негативні наслідки.

Можливо, вас зацікавить

Як виявити віруси на сайті й ліквідувати їх з ImunifyAV+

Уявіть, що ви перевіряєте свій вебсайт і виявляєте, що він поводиться дивно – реклама,...

| Оновлено: 17.06.2024

Файл robots.txt і як його правильно налаштувати

Robots.txt – це файл, який розміщується в папці сайту на хостингу і забороняє пошуковому...

| Оновлено: 29.05.2024

Як підключити до сайту Cloudflare

З цього гайду ви дізнаєтесь, як підключити до сайту Cloudflare усього за кілька кліків....

| Оновлено: 16.08.2023

Шифрування: типи і алгоритми. Що це, чим відрізняються і де використовуються?

Багато хто до цих пір недооцінює важливість SSL сертифікатів, але ж їх технологія лежить...

| Оновлено: 16.07.2020

Наш телеграм

з важливими анонсами, розіграшами й мемами

Приєднатися