Як працюють пошукові роботи

Уявіть бібліотеку, в якій зберігаються мільйони книг. Щоб знати, де шукати потрібний вам примірник, потрібно сформувати картотеку. Приблизно цим і займаються пошукові роботи в інтернеті. Їхнє завдання – обійти всі (чи майже всі) сторінки на 1,1 мільярді сайтів, вивчити інформацію на них і розмістити їх у видачі пошуковика.

Розуміння того, як працюють пошукові роботи, потрібне кожному власнику сайту, тож ми радо поділимося інформацією у цій статті. А також розповімо про «краулінговий бюджет» та як залучити пошукових роботів на сайт.

Що таке вебкраулер

Пошуковий робот, бот, павук, або краулер – це різні назви одного і того ж програмного забезпечення, або скрипта. Його завдання – переглядати сторінки в інтернеті, аналізувати отриману інформацію та індексувати їх.

Якщо інтернет прийнято називати всесвітньою павутиною, то пошукові боти – це ті самі павуки, що повзають по ній. Вони дізнаються, що нового сталось на тих чи інших вебсайтах, структурують цю інформацію, а потім видають користувачам за їхнім запитом.

Більшість пошукових систем використовують власні сканери, що працюють на основі певних алгоритмів. До прикладу, Googlebot для Google, Bingbot для Microsoft, Baiduspider для китайського пошуковика Baidu тощо.

15 найкращих пошукових систем у 2024 році

Типи пошукових роботів

Пошукових ботів програмують на різні завдання, за якими їх можна поділити на декілька типів:

- Focused web crawler. Завдання цього робота – шукати вміст, що об’єднаний певним параметром. Це може бути спільна тема або інформація з одного типу домену. На відміну від звичайних краулерів, такі не будуть переходити за всіма гіперпосиланнями, що є на сторінці. Вони оцінюватимуть їх на предмет релевантності.

- Incremental web crawler. Такі боти здійснюють повторні візити на сайти з метою оновити індексацію, замінити старі URL новими, де це можливо, тощо.

- Parallel web crawler. Ці роботи запускають одночасно кілька процесів, щоб збільшити ефективність завантаження.

- Distributed web crawler. Боти, що одночасно виконують свої функції на кількох сайтах.

Як працюють пошукові боти

Існує кілька етапів сканування, які з часом повторюються. Розповімо про кожен з них окремо.

Виявлення URL-адреси

Після того як ви опублікували нову сторінку, вебкраулер виявляє її. Він розуміє, що її потрібно просканувати. Також ця сторінка стає основою для майбутнього краулінгового циклу.

Краулінг

Коли пошукові боти виявили вашу сторінку, вони вносять її в свій план роботи, а потім починають по ній повзати. Контент, що включає метатеги, зображення, посилання, завантажується на сервер пошукової системи. Там він очікує, коли його проаналізують та проіндексують.

Аналіз

Потім відбувається той самий аналіз отриманих даних, щоб визначити як проіндексувати і ранжувати сторінку.

Також на цьому етапі відбувається ще один важливий процес – пошук URL-адрес. Аналізуючи дані, робот додає нещодавно виявлені посилання (включаючи редиректи) в чергу сторінок, які бот може відвідати. По суті це нові сторінки, які стануть основою для майбутніх краулінгових циклів.

Таким чином можна зробити висновок, що кількість URL-адрес з часом зростатиме в геометричній прогресії. До прикладу, на вашій сторінці знайшли 3 посилання, на кожному з цих посилань ще по 3 і так далі.

Індексація

Поки знаходяться нові посилання, та сторінка, яка була основною в цьому циклі, індексується. Тобто пошукові системи зберігають дані, отримані зі сторінки, щоб потім їх можна було оперативно надати користувачеві у відповідь на його запит.

Ранжування

На основі якості контенту, його релевантності пошуковим запитам, а також інших факторів сторінки отримують рейтинг. Потім згідно з цим рейтингом їх показують користувачам, які шукають відповіді на свій запит.

Кінець краулінгу

Рано чи пізно краулінг, включно з пошуком нових URL, закінчується. Причиною цього може стати виділений час, кількість сторінок, що були проскановані, глибина посилань, за якими переходили, тощо.

Повторний візит

Періодично пошукові роботи повторно відвідують сторінку, щоб перевірити наявність оновлень чи змін у структурі.

Як заманити пошукових роботів на свій сайт

Вебкраулери працюють автономно. Іншими словами, у вас немає можливості самостійно запустити сканування свого сайту. Але ви можете допомогти їм виконувати свої функції. Ось що для цього можна зробити:

- XML-карта сайту. Цей файл дає можливість пошуковим роботам зрозуміти, які сторінки на вашому сайті важливі і повинні бути проіндексовані в першу чергу. Як створити Sitemap (карту сайту) у WordPress читайте тут.

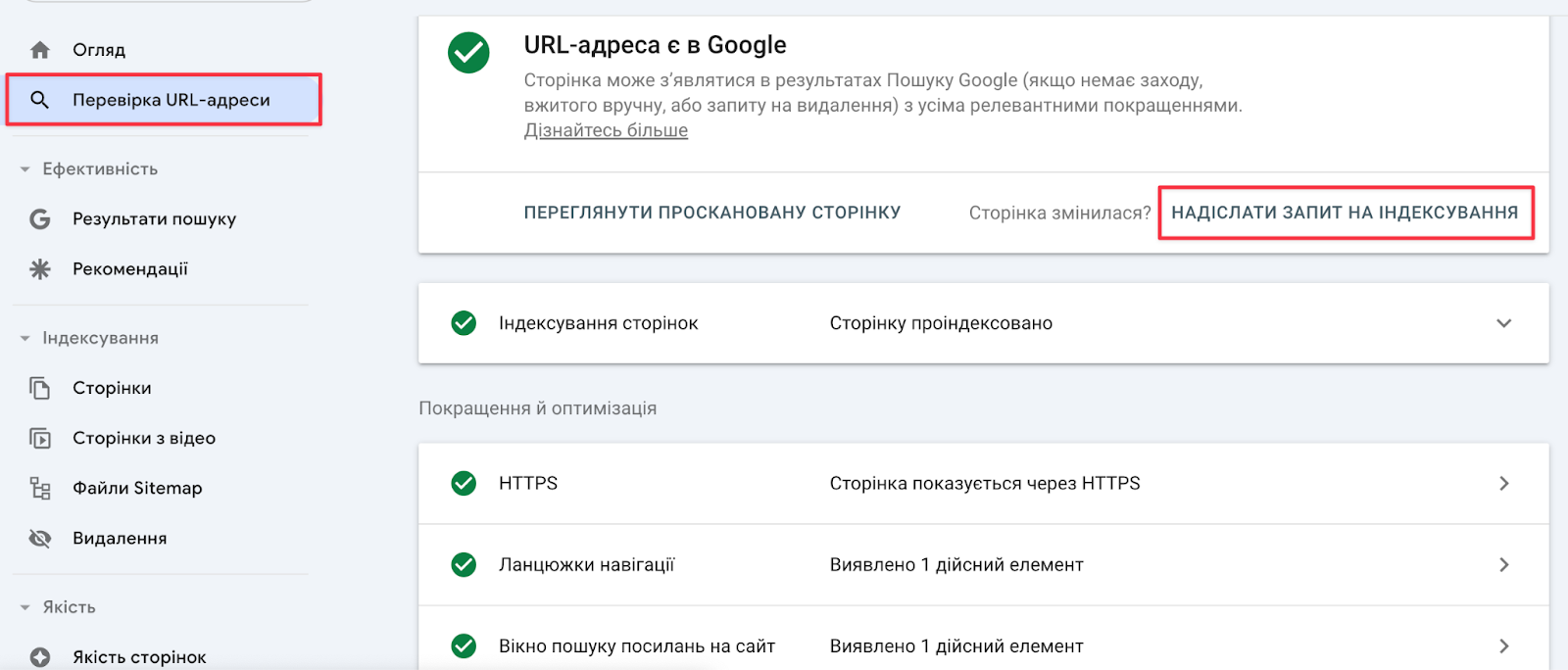

- Інструменти Google. У вас є можливість попросити Google повторно просканувати сайт. Це робиться в Google Search Console → розділ «Перевірка URL-адреси».

- IndexNow. Це інструмент, який дозволяє повідомляти пошукові системи про зміни, що відбулись на сайті. Таким чином вам не потрібно буде чекати, доки боти знову відвідають вашу сторінку, щоб просканувати і знайти на ній зміни. IndexNow сам повідомить їм про це. Однак цей інструмент не працює з Google.

- Працюйте над посиланнями і не тільки. Точно не відомо, які саме критерії впливають на частоту сканування вашого сайту ботами Google. Можна стверджувати, що основною частиною алгоритму, який використовує Google, є так званий PageRank. Він, у свою чергу, залежить від якості внутрішніх та зовнішніх посилань, а також page experience (наскільки користувачам зручно буде користуватись цією сторінкою, як вона відображається на мобільних пристроях, чи не з’являються там нав’язливі оголошення тощо).

- Оновлюйте сторінки. Провідний працівник Google Джон Мюллер говорить, що повторне сканування сторінок може відбуватись і кілька разів на день, і раз на кілька місяців. Але регулярне оновлення вмісту заохочує краулери заходити до вас частіше. Річ у тому, що Google прагне надавати користувачам якомога більш актуальну інформацію. Оновлюючи сторінки, ви показуєте, що також готові йти в ногу з часом.

- Чітка структура сайту. Якщо у вас на сайті все зрозуміло і структуровано, то краулерам легше по ньому повзати. Вони краще орієнтуються, розуміють ієрархію, а також індексують найбільш цінні сторінки. Тут також на допомогу прийде якісна внутрішня перелінковка. До речі, це й додатковий плюс для користувачів, і збільшення часу, який вони проводять на вашому сайті.

- «Здоров’я» сайту. Сайти, які повільно завантажуються і не «mobile-friendly», відштовхують від себе пошукових роботів. Ключову роль у швидкості завантаження сторінок сайту відіграє надійний хостинг, на якому файли цього сайту розміщуються. Як правильно підібрати хостинг розповіли тут.

Що таке краулінговий бюджет

Краулери імітують поведінку користувачів – вони переходять за посиланнями, які розміщені на сторінках вашого сайту. Але є певні обмеження, пов’язані з часом перебування на сайті, кількістю просканованих сторінок тощо.

Фактично краулінговий бюджет – це кількість сторінок вебсайту, які пошуковий робот може та готовий сканувати (краулити) за певний період часу. Пошукові системи, такі як Google, використовують цей термін, щоб описати баланс між тим, скільки сторінок пошуковий робот може сканувати та скільки сторінок він повинен сканувати.

Додатково краулінговий бюджет може бути зменшено, якщо посилання на вашій сторінці ведуть на неякісний контент (сторінки з помилками 404, сторінки зі спамом, декілька сторінок з ідентичним контентом тощо). Тому багато в чому саме від вас залежить, наскільки часто боти відвідуватимуть ваш сайт і як довго там будуть затримуватись.

Якщо ви не хочете, щоб деякі сторінки вашого сайту були проіндексовані, можете змінити налаштування файлу robots.txt. Подробиці про роботу з ним можна дізнатися в цьому матеріалі.

На завершення

Пам’ятайте, що від роботи вебкраулерів залежить, чи побачать ваш сайт потенційні читачі та покупці. Сподіваємось, що тепер ви трішки краще розумієте, що потрібно робити, щоб вони відвідували ваш сайт і піднімали його в топ видачі. Працюйте над якістю контенту, не забудьте створити карту сайту і регулярно оновлюйте інформацію.

Більше про те, що робити, якщо сайт не лізе у топ видачі, читайте тут.

А щоб прискорити свій сайт у 8 разів, розміщуйте його на супершвидкому NVMe Хостингу від HostPro. Домен .COM.UA, захист від DDoS та кваліфікована техпідтримка 24/7 – у кожному тарифі.

Можливо, вас зацікавить

Якщо ви хочете знати, скільки відвідувачів заходить на ваш сайт, звідки вони прийшли, як...

Неробочі, або як їх ще називають биті посилання на вашому сайті зменшують довіру з...

Будь-який хороший SEO-спеціаліст скаже вам, що всі заходи з підвищення рейтингу сайту повинні бути...

Наш телеграм

з важливими анонсами, розіграшами й мемами

Приєднатися