Как работают поисковые роботы

Представьте библиотеку, в которой хранятся миллионы книг. Чтобы знать, где искать нужный вам экземпляр, нужно сформировать картотеку. Примерно этим и занимаются поисковые роботы в интернете. Их задача – обойти все (или почти все) страницы на 1,1 миллиарде сайтов, изучить информацию на них и разместить их в выдаче поисковика.

Понимание того, как работают поисковые роботы, необходимо каждому владельцу сайта, поэтому мы с радостью поделимся информацией в этой статье. А также расскажем о «краулинговом бюджете» и как привлечь поисковых роботов на сайт.

Что такое веб-краулер

Поисковый робот, бот, паук, или краулер – это разные названия одного и того же программного обеспечения, или скрипта. Его задача – просматривать страницы в интернете, анализировать полученную информацию и индексировать их.

Если интернет принято называть всемирной паутиной, то поисковые боты – это те самые пауки, ползающие по ней. Они узнают, что нового произошло на тех или иных сайтах, структурируют эту информацию, а затем выдают пользователям по их запросу.

Большинство поисковых систем используют собственные сканеры, работающие на основе определенных алгоритмов. К примеру, Googlebot для Google, Bingbot для Microsoft, Baiduspider для китайского поисковика Baidu и тому подобное.

15 лучших поисковых систем в 2024 году

Типы поисковых роботов

Поисковых ботов программируют на разные задачи, по которым их можно разделить на несколько типов:

- Focused web crawler. Задача этого робота – искать содержимое, объединенное определенным параметром. Это может быть общая тема или информация из одного типа домена. В отличие от обычных краулеров, такие не будут переходить по всем гиперссылкам, которые есть на странице. Они будут оценивать их на предмет релевантности.

- Incremental web crawler. Такие боты совершают повторные визиты на сайты с целью обновить индексацию, заменить старые URL новыми, где это возможно, и т.д.

- Parallel web crawler. Эти роботы запускают одновременно несколько процессов, чтобы увеличить эффективность загрузки.

- Distributed web crawler. Боты, одновременно выполняющие свои функции на нескольких сайтах.

Как работают поисковые боты

Существует несколько этапов сканирования, которые со временем повторяются. Расскажем о каждом из них отдельно.

Обнаружение URL-адреса

После того как вы опубликовали новую страницу, веб-краулер обнаруживает ее. Он понимает, что ее нужно просканировать. Также эта страница становится основой для будущего краулингового цикла.

Краулинг

Когда поисковые боты обнаружили вашу страницу, они вносят ее в свой план работы, а затем начинают по ней ползать. Контент, включающий мета-теги, изображения, ссылки, загружается на сервер поисковой системы. Там он ожидает, когда его проанализируют и проиндексируют.

Анализ

Затем происходит тот самый анализ полученных данных, чтобы определить как проиндексировать и ранжировать страницу.

Также на этом этапе происходит еще один важный процесс – поиск URL-адресов. Анализируя данные, робот добавляет недавно обнаруженные ссылки (включая редиректы) в очередь страниц, которые бот может посетить. По сути это новые страницы, которые станут основой для будущих краулинговых циклов.

Таким образом можно сделать вывод, что количество URL-адресов со временем будет расти в геометрической прогрессии. К примеру, на вашей странице нашли 3 ссылки, на каждой из этих ссылок еще по 3 и так далее.

Индексация

Пока находятся новые ссылки, та страница, которая была основной в этом цикле, индексируется. То есть поисковые системы сохраняют данные, полученные со страницы, чтобы потом их можно было оперативно предоставить пользователю в ответ на его запрос.

Ранжирование

На основе качества контента, его релевантности поисковым запросам, а также других факторов страницы получают рейтинг. Затем согласно этому рейтингу их показывают пользователям, которые ищут ответы на свой запрос.

Конец краулинга

Рано или поздно краулинг, включая поиск новых URL, заканчивается. Причиной этого может стать выделенное время, количество страниц, которые были просканированы, глубина ссылок, по которым переходили, и т.д.

Повторный визит

Периодически поисковые роботы повторно посещают страницу, чтобы проверить наличие обновлений или изменений в структуре.

Как заманить поисковых роботов на свой сайт

Веб-краулеры работают автономно. Другими словами, у вас нет возможности самостоятельно запустить сканирование своего сайта. Но вы можете помочь им выполнять свои функции. Вот что для этого можно сделать:

- XML-карта сайта. Этот файл дает возможность поисковым роботам понять, какие страницы на вашем сайте важны и должны быть проиндексированы в первую очередь. Как создать Sitemap (карту сайта) в WordPress читайте здесь.

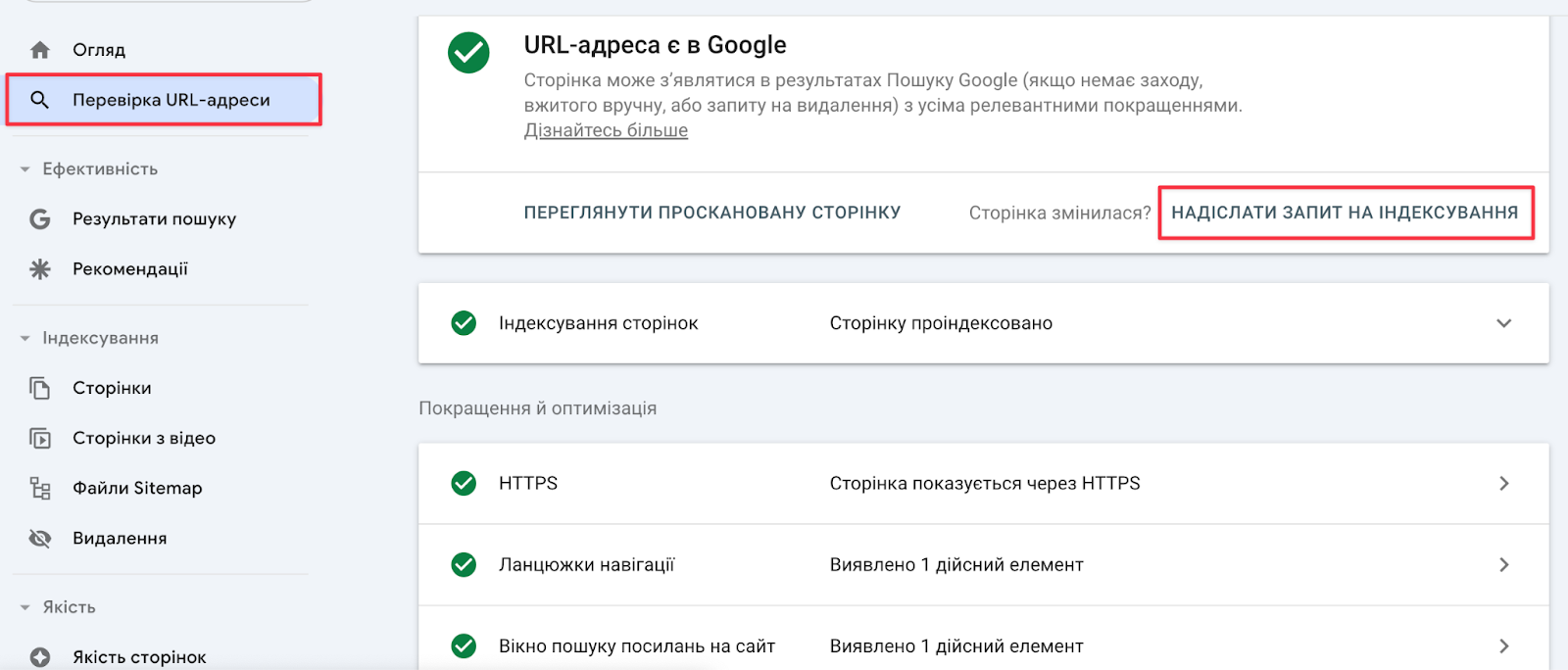

- Инструменты Google. У вас есть возможность попросить Google повторно просканировать сайт. Это делается в Google Search Console → раздел «Проверка URL-адреса».

- IndexNow. Это инструмент, позволяющий сообщать поисковым системам об изменениях, произошедших на сайте. Таким образом, вам не нужно будет ждать, пока боты снова посетят вашу страницу, чтобы просканировать и найти на ней изменения. IndexNow сам сообщит им об этом. Однако этот инструмент не работает с Google.

- Работайте над ссылками и не только. Точно не известно, какие критерии влияют на частоту сканирования вашего сайта ботами Google. Можно утверждать, что основной частью алгоритма, используемого Google, является так называемый PageRank. Он, в свою очередь, зависит от качества внутренних и внешних ссылок, а также page experience (насколько пользователям удобно будет использовать эту страницу, как она отображается на мобильных устройствах, не появляются ли там навязчивые объявления и т.д.).

- Обновляйте страницы. Ведущий работник Google Джон Мюллер говорит, что повторное сканирование страниц может происходить и несколько раз в день и раз в несколько месяцев. Но регулярное обновление содержимого поощряет краулер заходить к вам чаще. Дело в том, что Google стремится предоставлять пользователям более актуальную информацию. Обновляя страницы, вы показываете, что готовы идти в ногу со временем.

- Четкая структура сайта. Если у вас на сайте все понятно и структурировано, то краулерам легче по нему ползать. Они лучше ориентируются, понимают иерархию и индексируют наиболее ценные страницы. Здесь также на помощь придет качественная внутренняя перелинковка. Кстати, это и дополнительный плюс для пользователей, и увеличение времени, которое они проводят на вашем сайте.

- «Здоровье» сайта. Медленно загружаемые и не «mobile-friendly» сайты отталкивают от себя поисковых роботов. Ключевую роль в скорости загрузки страниц сайта играет надежный хостинг, на котором размещаются файлы этого сайта. Как правильно подобрать хостинг, рассказали здесь.

Что такое краулинговый бюджет

Краулеры имитируют поведение пользователей – они переходят по ссылкам, размещенным на страницах вашего сайта. Но есть определенные ограничения, связанные с временем пребывания на сайте, количеством просканированных страниц и т.д.

Фактически краулинговый бюджет – это количество страниц веб-сайта, которые поисковый робот может и готов сканировать (краулить) за определенный период времени. Поисковые системы, такие как Google, используют этот термин, чтобы описать баланс между тем, сколько страниц поисковик может сканировать и сколько страниц он должен сканировать.

Дополнительно краулинговый бюджет может быть уменьшен, если ссылки на вашей странице ведут на некачественный контент (страницы с ошибками 404, страницы со спамом, несколько страниц с идентичным контентом и т.п.). Поэтому во многом именно от вас зависит, насколько часто будут посещать ваш сайт и как долго там будут задерживаться.

Если вы не хотите, чтобы некоторые страницы вашего сайта были проиндексированы, вы можете изменить настройки файла robots.txt. Подробности о работе с ним можно узнать в этом материале.

В завершение

Помните, что от работы веб-краулеров зависит, увидят ли ваш сайт потенциальные читатели и покупатели. Надеемся, что теперь вы немного лучше понимаете, что нужно делать, чтобы они посещали ваш сайт и поднимали его в топ выдачи. Работайте над качеством контента, не забудьте создать карту сайта и регулярно обновляйте информацию.

Больше о том, что делать если сайт не лезет в топ выдачи, читайте здесь.

А чтобы ускорить свой сайт в 8 раз, размещайте его на супербыстром NVMe Хостинге от HostPro. Домен .COM.UA, защита от DDoS и квалифицированная техподдержка 24/7 – в каждом тарифе.

Возможно, вас заинтересует

Если вы хотите знать, сколько посетителей заходит на ваш сайт, откуда они пришли, как...

Нерабочие, или как их еще называют битые ссылки на вашем сайте уменьшают доверие со...

Любой хороший SEO-специалист скажет вам, что все мероприятия по повышению рейтинга сайта должны быть...

Наш телеграм

с важными анонсами, розыгрышами и мемами

Присоединиться