Система хранения данных EMC запущена в эксплуатацию

В прошлой статье мы рассказали вам про установку нового дискового массива Clarion EMC AX4-5F. Сегодня мы хотим рассказать вам о том, как мы подключили и настроили эту систему хранения данных. А также покажем производительность этого решения для разных систем Windows и Linux.

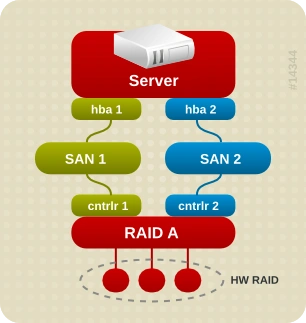

Первым делом мы подключили наш массив по уже наработанной нами схеме используя отказоустойчивый принцип. Система имеет на каждом контроллере по два включения в свичи. Таким образом выход из строя одного свича или контроллера не остановит систему, а ваши ресурсы будут доступны и дальше. Как в случае с предыдущими системами хранения данных, новый контроллер подключён к серверам на скорости 8Гбит/сек, для этого мы используем оптику от Molex тип LC_LC. И так кластер настроен и подключён к оборудованию. После того как каждый вычислительный узел получил доступ к новому серверу мы принялись делать тесты производительности.

Дисковый массив был разбит на 3 LUN’а, каждый из которых собран в 10 RAID, что позволяет получить высокую надёжность сохранности данных, а также наилучшую производительность чтения/записи данных.

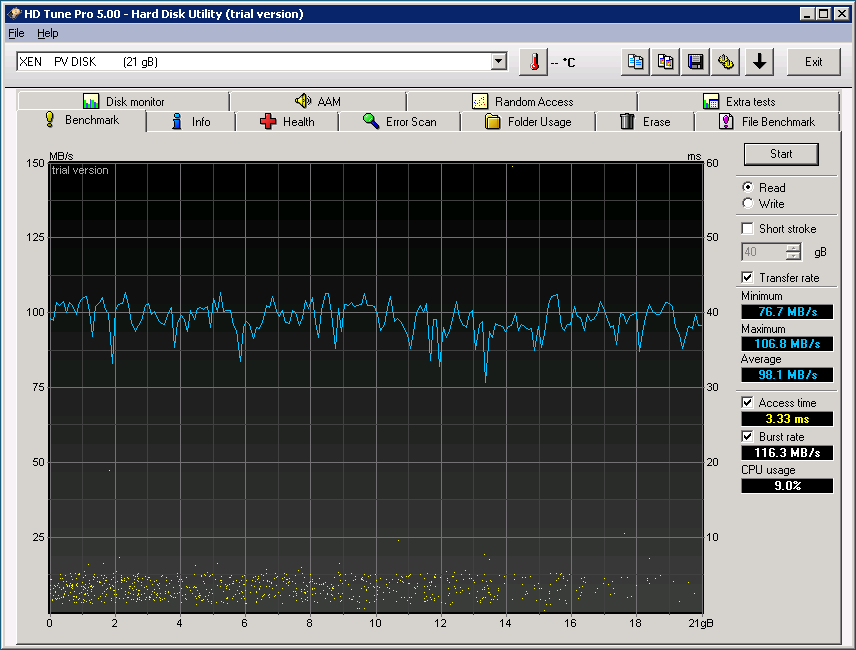

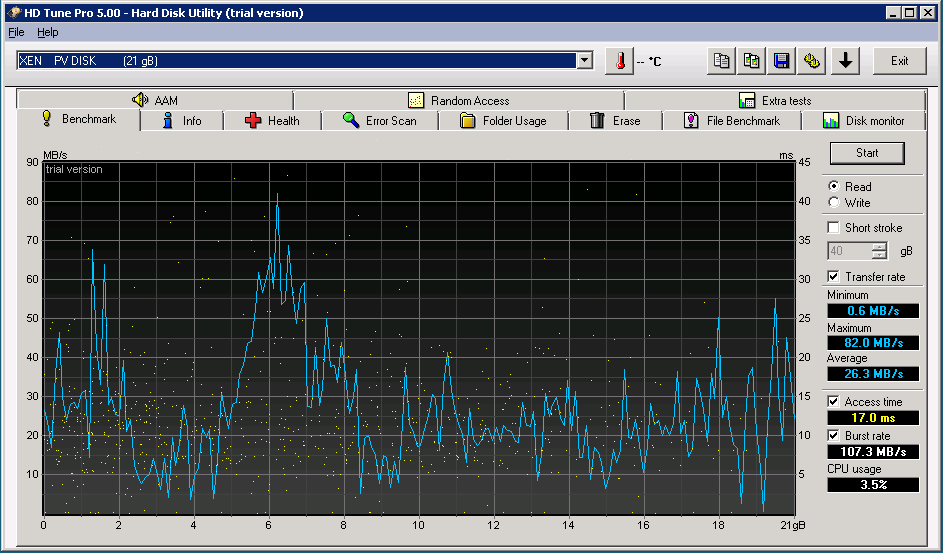

Нас очень волновал вопрос производительности Windows машин под XEN, ранее у нас были проблемы с производительностью серверов на системе хранения данных Infortrend. В новой системе таких проблем нету, скорость работы дискового массива имеет вполне приемлемый результат. Для сравнения две картинки:

Clarion AX4-5F

Infortrend S24F

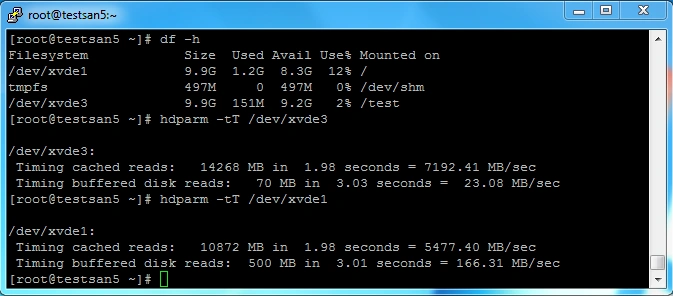

Давайте теперь сравним скорость работы диска в Linux. Нами был выбран стандартный шаблон CentOS 6.2 x64, на нём мы установили два диска от разных массивов. И при помощи утилиты hdparm произвели замер производительности чтения данных с обоих дисков.

Как видно /dev/xvde3 существенно проигрывает по скорости диску /dev/xvde1

В обоих случаях новый дисковый массив быстрее предыдущего. Основным преимуществом по сравнению с Infortrend стало наличие 15k SAS дисков, именно за счёт них и получаем такую скорость чтения/записи.

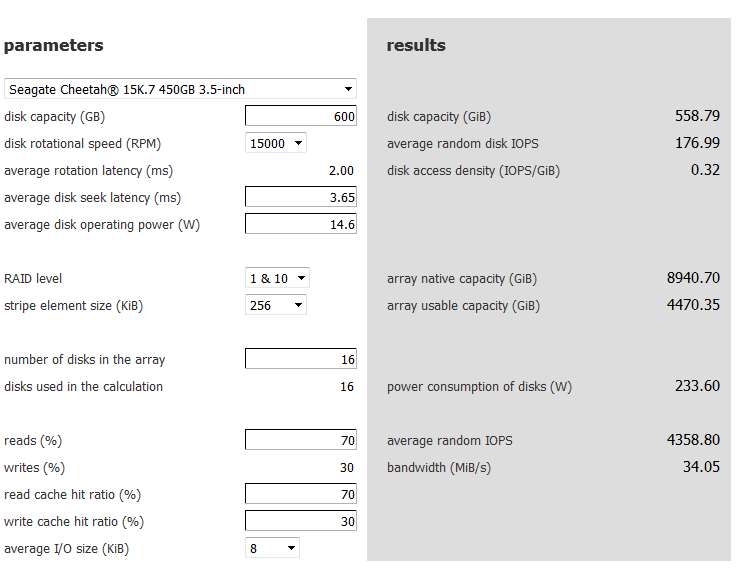

Затем нам стало интересно, а сколько же операций ввода вывода сможет обслуживать данный массив? Для начала мы воспользовались онлайн калькулятором на сайте http://www.wmarow.com/strcalc/strcalc.html подставили параметры своих дисков и получили очень интересный результат, при условии что наш массив на 70% будет использоваться на чтение, 30% на запись мы получим среднюю нагрузку в 4300 IOPS, с учётом того что наш массив использует 3 LUN’а, мы получаем число в 12900 IOPS на весь сторедж.

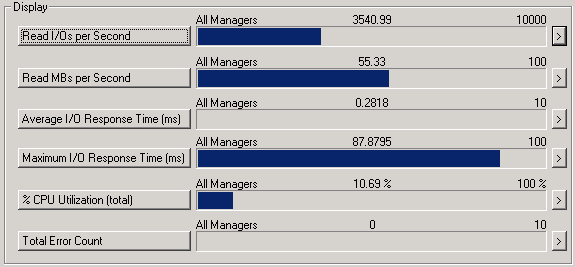

Но доверять онлайн калькулятору нельзя, он может служить лишь наглядным примером при построении системы до ввода её в эксплуатацию. Поэтому мы воспользуемся утилитой iometr, которая покажет нам производительность нашего массива на рабочем сервере. Установив утилиту мы произвели все необходимые нам замеры и получили следующие данные:

Как видно настоящий тест показал немного меньшее число операций.

Как это отобразится на наших пользователях? Тут всё просто, новый массив пройдёт проверку «боем» после чего мы будем мигрировать наших клиентов на него, тем самым вы сможете получить большую скорость работы вашего сервера в облаке. Таким образом новый массив увеличит скорость работы ваших приложений, сайтов, и баз данных. При этом будет сохранена надёжность кластера.

Вот пожалуй и всё, что мы хотели вам рассказать про новую систему хранения данных для нашего облака.

Возможно, вас заинтересует

20 апреля, мы обновили наш Cloud хостинг. Главным нововведением стала возможность запускать виртуальный сервер...

Только что получили новенькие сервера XEON от Entry. 8Гб памяти, SSD диск и встроенный...

Хорошая новость для тех, кто хочет попробовать облачные услуги. Мы запустили новую зону в...

Наш телеграм

с важными анонсами, розыгрышами и мемами

Присоединиться