Вредоносные боты на сайте – как их обнаружить и заблокировать

Знаете ли вы, что значительную часть онлайн-трафика создают боты? Эти автоматизированные алгоритмы лежат в основе различных онлайн-активностей, запрограммированные на выполнение целого ряда действий, которые варьируются от индексации веб-страниц для поисковых систем до выполнения повторяющихся задач.

В этой статье рассмотрим, что такое бот-трафик, какие бывают боты, как выявить вредоносный трафик ботов на сайте и остановить его через блокировку различными способами.

Что такое бот-трафик?

Бот-трафик – это активность на веб-сайте или онлайн-платформе, генерируемая ботами. Посещения веб-сайтов ботами неизбежны, независимо от того, это крупная онлайн-платформа с высоким трафиком или недавно запущенный стартап.

Каждый бот, который получает доступ к веб-сайту, увеличивает его нагрузку, что при чрезмерной активности может иметь негативные последствия для корректного функционирования сайта и сервера, с которого тот работает. Невыборочное потребление ресурсов неизбежно приводит к замедлению работы веб-сайтов, независимо от их размещения.

Важно отметить! Не все боты на вашем сайте являются вредоносными!

Ботов можно условно разделить на два типа: полезные боты (их еще называют «белые» боты) и вредоносные боты (вредоносные программы).

Полезные боты разрабатываются с соблюдением этических принципов и норм, гарантируя, что их деятельность не наносит вреда пользователям и не нарушает их конфиденциальность. Обычно правила для корректной работы бота определяются в файле robots.txt веб-сайта. Полезный бот должен сначала проверять этот файл и, следуя указанным правилам, выполнять запрограммированные действия.

Типы полезных ботов

Существует множество типов полезных ботов, каждый из которых имеет свое предназначение:

1. Боты поисковых систем – это боты, которые сканируют веб-содержимое для того, чтобы индексировать информацию для поисковых систем, делая ее доступной для пользователей. Сюда можно отнести Googlebot, Baiduspider, Bingbot и другие.

Важно заметить! Иногда этим ботам нет смысла сканировать ваш вебсайт. Например, если вы не обслуживаете китайский или российский рынки, Baiduspider и YandexBot не должны сканировать ваш сайт, ведь это приведет к повышенной нагрузке на сервер.

2. Боты-агрегаторы предназначены для автоматического сбора информации из различных источников с целью создания полных каталогов или списков содержимого в соответствии с предпочтениями своих пользователей. Примером может служить бот Feedly Fetcher.

3. Боты бизнес-аналитики – боты, анализирующие отзывы о продуктах, комментарии в социальных сетях и другие данные, предоставляя компаниям ценную информацию о восприятии бренда и поведении клиентов.

4. Боты для мониторинга сайта используются как инструмент для отслеживания корректности функционирования веб-сайта и сервера в целом. Этот тип ботов постоянно проверяет состояние сайта, в частности доступность, скорость загрузки и функциональность. Благодаря этому они могут выявить проблемы, которые могут повлиять на посетителей, например, медленное время загрузки, нерабочие ссылки или ошибки сервера. После обнаружения проблемы бот отправляет уведомление, поэтому владелец сайта может быстро ее решить и тем самым поддержать его бесперебойную работу. Некоторые примеры этих ботов: Uptime Robot, StatusCake и Pingdom.

5. Чат-боты – это программы, которые могут имитировать разговор с людьми. Они используются для автоматизации повторяющихся задач, таких как ответы на вопросы в чатах. Чат-боты работают с помощью заранее определенных ответов на конкретные триггеры. Многие из них уже используют искусственный интеллект (ИИ) для более естественного разговора, лучшего понимания запросов и выполнения сложных задач.

Типы вредоносных ботов

В противовес полезным ботам, вредоносные боты – это программные агенты, используемые для различных злонамеренных целей, таких как распространение спама, кража конфиденциальных данных, атаки на веб-сайты и другие виды киберпреступности.

Последствия вредоносных ботов для веб-сайтов могут быть серьезными. Они могут повлечь за собой снижение скорости работы сайта, нарушение его функциональности, кражу конфиденциальной информации, распространение вирусов и других вредоносных программ, а также повлиять на репутацию сайта в глазах поисковых систем. Таким образом, эти вредоносные программы, подобно своим полезным аналогам, способны выполнять автоматизированные действия, но с враждебной целью.

Вот некоторые из распространенных типов вредоносных ботов:

- Спам-боты – рассылают нежелательную почту, рекламу и другие навязчивые сообщения. Спам-боты используются для злонамеренных целей, таких как фишинг, распространение вредоносного программного обеспечения или продвижение спам-продуктов или услуг.

- DDoS-боты – переполняют сервер веб-сайта очень большим количеством трафика, из-за чего он становится недоступным для легитимных пользователей. Это может привести к простою, потере прибыли и ущербу репутации веб-сайта.

- Боты-сканеры – боты, просматривающие веб-страницы по гиперссылкам с целью получения и индексирования веб-содержимого. Вредные сканеры также сканируют веб-сайт на наличие содержимого, но не с намерением индексировать его, а чтобы скопировать его содержимое и контент.

- Боты-скраперы – это боты, которые считывают данные с веб-сайтов, чтобы сохранить их в автономном режиме и позволить их повторное использование. Это может иметь форму копирования всего содержимого веб-страниц или копирования веб-содержимого для получения определенных точек данных, таких как названия и цены продуктов на сайтах электронной коммерции.

Сбор и анализ содержимого веб-сайтов – это серая зона. В некоторых случаях считывание является законным и может быть разрешено владельцами веб-сайтов. В других случаях операторы ботов могут нарушать условия использования веб-сайта или, что еще хуже, использовать сканирование для похищения конфиденциального и защищенного авторским правом содержимого.

Вредоносные боты создаются с намерением нанести вред, использовать уязвимости или нарушить работу сервисов.

С другой стороны, даже безвредные боты, разработанные для законных целей, таких как индексация поисковых систем, мониторинг веб-сайтов или обслуживание клиентов, могут непреднамеренно создавать чрезмерную нагрузку на серверы. Например, если поисковый бот слишком агрессивно сканирует веб-сайт, он может потреблять большое количество пропускной способности и серверных ресурсов, что влияет на производительность веб-сайта для законных пользователей.

Общие признаки вредоносного трафика ботов

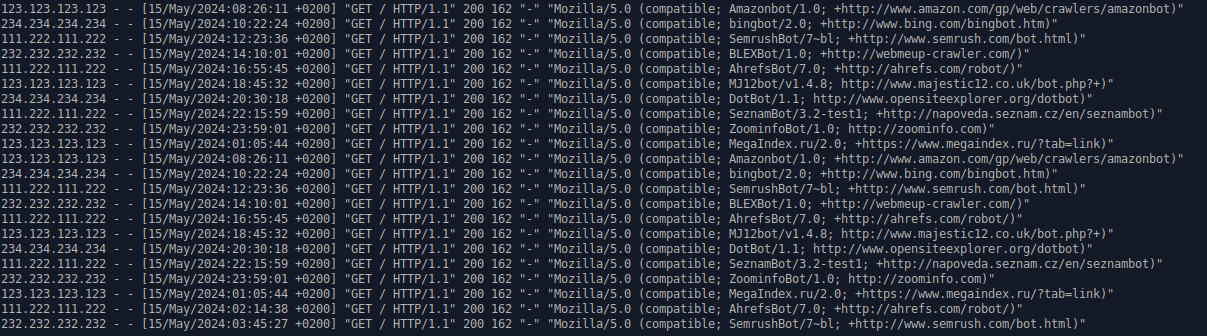

Признаки того, что ваш веб-сайт атакован ботами:

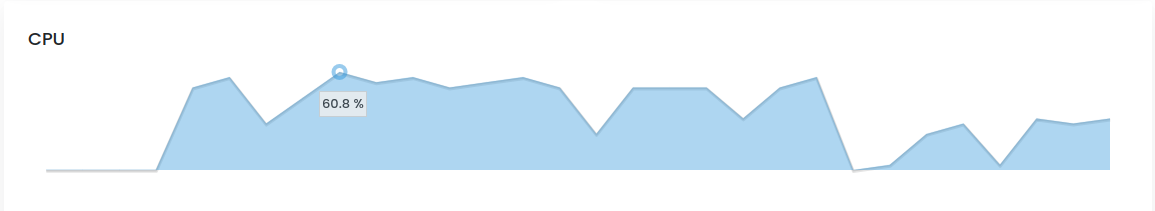

- Внезапные скачки трафика.

Боты, как правило, появляются массово, особенно для сканирования и DDoS-атак, то есть вы увидите внезапный необъяснимый всплеск просмотров страниц. - Проблемы с производительностью сервера.

Поскольку боты появляются в таких больших объемах, ваши серверы могут не справиться с дополнительной нагрузкой, что замедлит работу веб-сайта для всех пользователей. Как только вы добавите больше ресурсов сервера, больше ботов смогут проникнуть, обострив проблему. - Высокий показатель отказов.

Поскольку боты запрограммированы на выполнение определенного действия, достигнув своей цели (например, просканировав страницу сайта), боты покидают ваш сайт. Это может выглядеть так, будто значительная часть посетителей сайта покидает его сразу после просмотра главной страницы. Подобная активность приводит к искусственно завышенному показателю отказов, поскольку боты больше никак не взаимодействуют с сайтом. - Ненормальная продолжительность сеанса.

Люди, как правило, остаются на веб-сайте по крайней мере несколько секунд, но не дольше нескольких минут на одной странице. Продолжительность сеанса в несколько минут может указывать на трафик бота.

Как остановить трафик ботов?

Не существует единого решения, которое бы могло полностью решить ситуацию с ботами для всех сайтов. Но в этой статье мы все же рассмотрим несколько действенных способов, которые вы уже сегодня сможете применить на своем сайте.

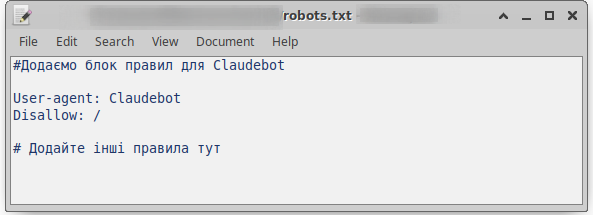

Файл robots.txt – сборщик наших правил для ботов

Файл robots.txt – это первоочередной указатель по сайту для ботов. Он определяет, какие части вашего сайта могут быть просканированы ботами, а какие – нет. Это важный инструмент для контроля доступа к веб-ресурсу и поддержания оптимальной видимости в поисковых системах.

Как работает файл robots.txt?

Поисковые боты перемещаются в интернете по разветвленной сети ссылок, страниц и веб-сайтов, старательно изучая каждую ссылку, на которую наталкиваются.

Однако, наткнувшись на файл robots.txt на сайте, бот приоритетно читает его, прежде чем продолжить сканирование. Этот файл, по сути, действует как набор инструкций, указывая боту, какие области сайта открыты для изучения, а какие следует исключить из процесса индексирования.

Синтаксис robots.txt

Файл robots.txt состоит из одного или нескольких блоков, которые описывают каждое правило. Каждый блок состоит из двух строк:

- Определение «User-agent» – строка определяет конкретный веб-сканер, к которому применяются следующие правила.

- Инструкция или правило (запрет или разрешение на выполнение действий).

Простой блок может иметь такой вид:

User-agent: Claudebot

Disallow: /Объяснение блока:

- User-agent: Claudebot – это означает, что эта конкретная строка инструкций предназначена для бота с названием „Claudebot“.

- Disallow: / – эта строка запрещает Claudebot индексировать главную страницу вашего сайта и любые подстраницы на том же уровне.

Важно!

Использование символа «*» в строке «User-agent:» со следующей директивой «Disallow: /» устанавливает правило запрета сканирования всего вашего сайта всеми ботами:

User-agent: *

Disallow: /Это может привести к тому, что ваш сайт станет невидимым в результатах поиска, хотя данный способ запрета индексации сайта может быть использован при разработке нового проекта.

Если вы, наоборот, хотите разрешить всем поисковым системам сканировать весь ваш сайт, ваш блок правил будет выглядеть так:

User-agent: *

Allow: /Объяснение блока:

- User-agent: * – строка указывает, что правило касается всех ботов, которые посещают ваш сайт.

- Allow: / – правило, позволяющее индексировать все страницы сайта.

Правила запрета и разрешения сканирования ботами веб-сайтов можно сочетать. Файл robots.txt позволяет вам четко контролировать, какие части вашего сайта могут сканировать и индексировать поисковые системы.

Вы можете использовать комбинацию правил Disallow и Allow для создания более детальных правил сканирования. Например, можно заблокировать доступ ботов ко всему сайту, а затем разрешить им сканировать только несколько страниц:

User-agent: *

Disallow: /

Allow: /index.html

Allow: /about-us.html

Allow: /contact-us.htmlТо есть, правило «Allow» позволяет поисковым системам сканировать подкаталог или определенную страницу, даже в каталоге, который ранее было запрещено сканировать.

Важно! Для установки правил для каждого бота нужно отдельно создавать новый блок.

User-agent: BaiduBot

Disallow: /

Disallow: /admin/

User-agent: Claudebot

Disallow: /

User-agent: PetalBot

Disallow: /Ограничение частоты сканирования веб-сайта

Правило Crawl-Delay позволяет установить задержку сканирования во избежание чрезмерной нагрузки на сервер и замедления работы веб-сайта.

Например, нужно установить правило, чтобы все боты ждали 20 секунд после каждого действия сканирования. Установить задержку на 20 секунд можно следующим образом:

User-agent: *

Crawl-delay: 20ВАЖНО ОТМЕТИТЬ! Хотя правило Crawl-delay может быть включено в файлы robots.txt, это не гарантированный способ контролировать частоту сканирования вашего сайта, поскольку некоторые боты могут его игнорировать. Например, для Google это правило является устаревшим. Если вы хотите установить скорость сканирования для Googlebot, вам нужно будет сделать это в Search Console.

Как создать robots.txt?

Файл robots.txt всегда должен быть на уровне корневого домена, то есть размещаться в корневой директории сайта. Для домена example.com файл robots.txt находится по адресу example.com/robots.txt. Если он будет размещен в другом месте, сканеры будут игнорировать прописанные правила, поскольку не будут находить этот файл.

Итак, создаем текстовый файл robots.txt в корневой директории нашего сайта. Для этого откройте текстовый редактор. Вы можете использовать любой текстовый редактор, например Блокнот, TextEdit или Vim.

Введите следующие строки:

User-agent: *

Disallow: /

Sitemap: https://www.example.com/sitemap.xml

# Добавьте другие правила здесьОбъяснение блока:

- User-agent: * – указывает, что эти правила применяются ко всем вебсканерам.

- Disallow: / – указывает, что все страницы в корневом каталоге вашего вебсайта (например, https://example.com/) не должны индексироваться.

- Sitemap: https://www.example.com/sitemap.xml – указывает поисковым системам на расположение вашей карты сайта. Карта сайта – это список всех страниц на вашем вебсайте.

Сохраните файл как robots.txt. Убедитесь, что вы сохранили файл с суффиксом .txt.

Загрузите файл robots.txt в корневой каталог вашего веб-сайта. Корневой каталог – это место, где находится главная страница вашего веб-сайта. Обычно вы можете загрузить файлы на свой веб-хостинг с помощью FTP или файлового менеджера.

К сожалению, боты воспринимают файл robots.txt только как рекомендацию. Некоторые боты игнорируют robots.txt и продолжают сканировать веб-сайт. Описанные выше шаги могут быть неэффективными для отсеивания вредоносных ботов и целенаправленных атак.

Блокировка отдельных IP-адресов

Если вы сталкиваетесь с вредоносной активностью или чрезмерными запросами с определенных IP-адресов от ботов, вы можете рассмотреть возможность их блокировки по отдельным IP-адресам.

Вы можете использовать несколько методов для их блокировки.

Использование брандмауэра (фаервола)

Брандмауэр – это программное обеспечение, которое контролирует и фильтрует сетевой трафик, поступающий на ваш веб-сайт.

Брандмауэр действует как барьер между вашим веб-сайтом и интернетом. Он анализирует каждый пакет данных, который поступает на ваш сайт, и решает, разрешить его или заблокировать.

Важно!

- прежде чем блокировать любые IP-адреса, убедитесь, что вы правильно идентифицировали их как источник злонамеренной активности;

- блокировка легитимных IP-адресов может привести к проблемам с доступом для ваших пользователей;

- всегда делайте резервные копии своих данных и настроек, прежде чем вносить какие-либо изменения в конфигурацию.

Использование брандмауэра CSF на Shared-хостинге в HostPro

CSF (ConfigServer Security & Firewall) – это мощный брандмауэр для серверов Linux, который обеспечивает высокую безопасность и удобное управление. На shared-хостинге в HostPro, где CSF установлен по умолчанию, он помогает защищать сайты от различных вредоносных действий, таких как DDoS-атаки, попытки взлома и вредоносные боты.

Основные функции CSF:

- фильтрация трафика: CSF фильтрует входящий и исходящий трафик, разрешая только легитимный;

- блокировка IP: автоматическая блокировка IP-адресов, которые оказываются вредоносными;

- ограничение доступа: возможность установки правил для доступа к серверу;

- логирование: ведение логов для анализа атак и выявления угроз.

Важно! Блокировка IP-адресов через CSF на shared-хостинге HostPro возможна только через обращение в техническую поддержку.

Использование брандмауэра на VPS в HostPro

Для VPS-хостинга в HostPro, брандмауэр можно как активировать вместе с установкой панели управления, так и выполнить настройку без панели управления.

Многие панели управления, такие как cPanel, Plesk, CWP или CyberPanel, имеют встроенные брандмауэры в качестве дополнительного программного обеспечения. cPanel и CWP используют CSF в качестве встроенного брандмауэра, а CyberPanel – Fail2ban.

Также вы можете установить и настроить брандмауэр на VPS без использования панели управления, однако этот метод является более сложным и требует знаний командной строки.

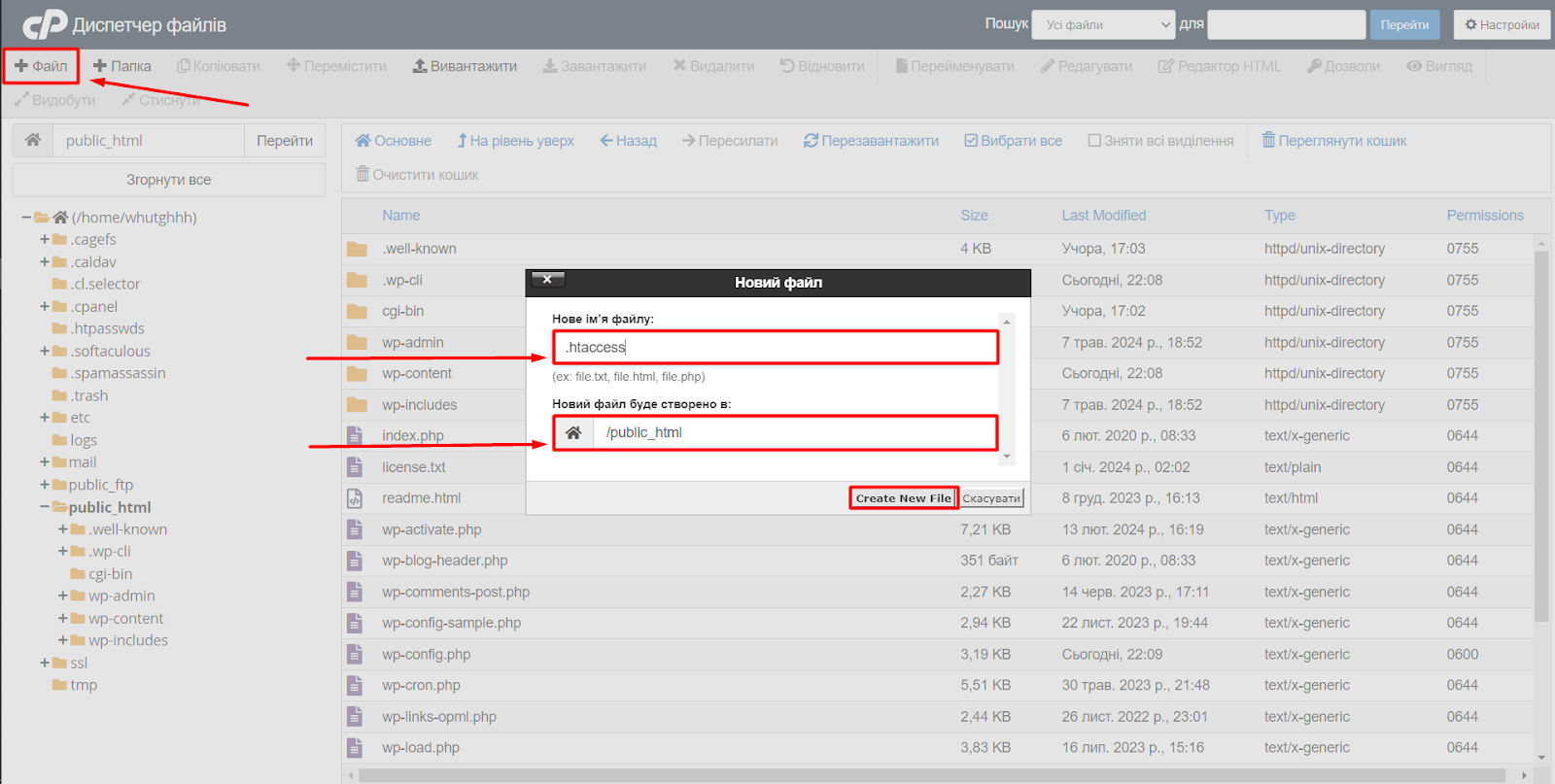

Блокировка ботов с помощью .htaccess

Файл .htaccess – это конфигурационный файл, который используется для управления различными аспектами функционирования веб-сайта. Он позволяет разработчикам и администраторам серверов изменять «поведение» сервера для определенных каталогов или URL-адресов без внесения изменений в основной конфигурационный файл веб-сервера.

Вы можете использовать .htaccess для блокировки доступа к вашему веб-сайту с определенных IP-адресов. Этот метод блокировки может быть довольно эффективной защитой от вредоносных ботов.

Важно отметить! Внесение неправильных изменений в файл .htaccess может привести к проблемам с работой вашего сайта. Поэтому рекомендуется создавать резервные копии файлов .htaccess перед внесением каких-либо изменений. Далее расскажем, как можно заблокировать ботов с помощью .htaccess.

Создайте файл .htaccess

Если в вашей корневой папке сайта нет файла .htaccess, создайте его. Для создания файла .htaccess подойдет как локальный текстовый редактор, так и диспетчер файлов панели управления.

Примечание!

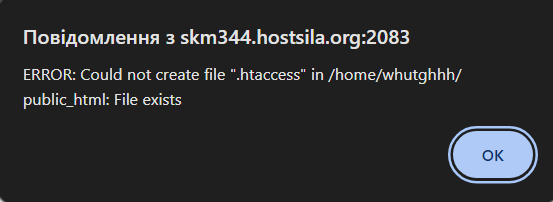

Вы можете столкнуться с ситуацией, когда в перечне файлов сайта не будет отображаться файл .htaccess, но при его создании возникнет ошибка. ERROR: Could not create file «.htaccess» in /home/whutghhh/public_html: File exists.

Некоторые файлы, включая .htaccess, по умолчанию скрыты, чтобы не загромождать список файлов и избежать их случайного удаления. Это распространенная практика на веб-серверах, ведь .htaccess содержит важные настройки, которые могут привести к проблемам, если их случайно изменить.

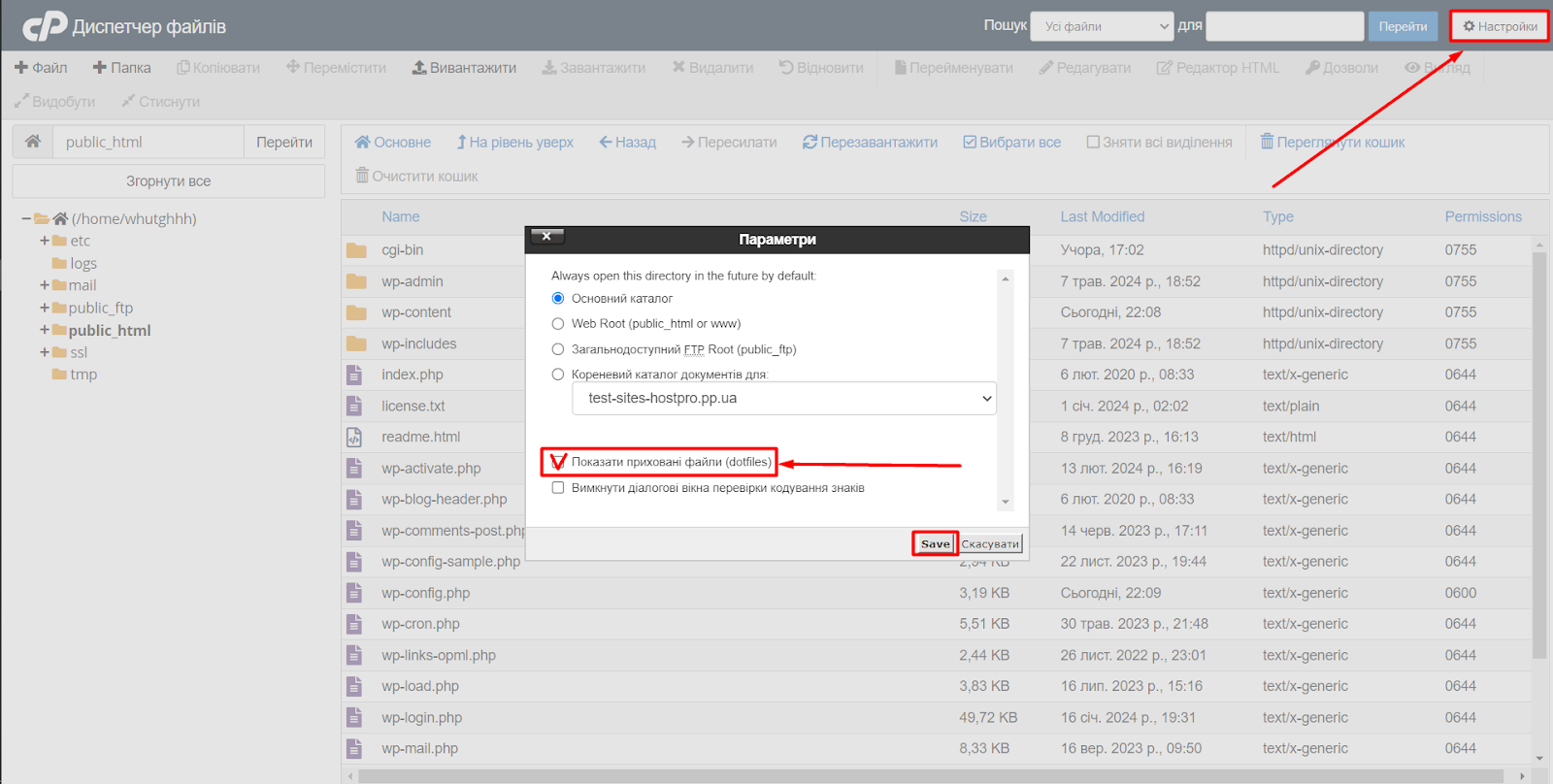

Чтобы найти скрытый .htaccess, вам нужно включить опцию отображения скрытых файлов в вашем файловом менеджере.

Добавьте правило блокировки

Откройте файл .htaccess и добавьте в него следующий код:

# Блокировка по IP-адресу

Order allow,deny

Deny from 192.168.1.100

Deny from 192.168.1.101Данное правило означает, что приведенные IP-адреса заблокированы и не смогут получить доступ к вашему веб-сайту.

Важно! Добавив в конце данного правила строку «Allow from all», вы разрешите доступ к веб-сайту со всех остальных IP-адресов. Поскольку «Allow from all» размещено после директивы «Deny», данное правило фактически позволяет посещать сайт всем IP, кроме IP-адреса, явно запрещенного в предыдущей строке.

Также блокировку вредоносных ботов можно выполнять через блокировку агентов пользователя.

Для этого в файл .htaccess добавьте новое правило:

# Блокировка по агенту пользователя

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} UserAgentName [NC]

RewriteRule .* - [F,L]Данное правило является шаблоном, в котором вместо «UserAgentName» необходимо указать конкретного агента пользователя. Например:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ClaudBot [NC]

RewriteRule .* - [F,L]Объяснения по строкам:

- RewriteEngine On

Эта строка активирует модуль перенаправления запросов Apache, который необходим для работы следующих правил. - RewriteCond %{HTTP_USER_AGENT} ClaudBot [NC]

Используется для проверки строки User-Agent в заголовке HTTP-запроса. Если строка User-Agent содержит слово «ClaudBot» (в нечувствительном к регистру режиме), условие будет считаться истинным. - RewriteRule . — [F,L]*

Эта строка правила определяет, что делать, если условие RewriteCond будет истинным. В данном случае символ «.» используется как подстановка, которая соответствует любому URL-адресу на вашем веб-сайте. «- [F,L]» указывает, что запрос следует немедленно завершить с кодом ошибки 403 (Запрещено) и не обрабатывать его дальше.

В следующем примере правила вы можете видеть, как можно расширить эту логику, чтобы блокировать нескольких ботов одновременно. Просто добавьте дополнительные условия RewriteCond, разделенные «|» (боковой слеш), чтобы охватить всех ботов, которых вы хотите заблокировать. Например:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (SCspider|Textbot|s2bot).*$ [NC]

RewriteRule .* - [F,L]Этот код будет блокировать ботов с именами «SCspider», «Textbot» и «s2bot». Вы можете добавить сколько угодно условий RewriteCond, разделенных «|», чтобы охватить более широкий спектр ботов.

Сохраните файл .htaccess

Сохраните файл .htaccess в корневой папке вашего сайта.

Помните, что важно регулярно обновлять список IP-адресов и агентов пользователей ботов, чтобы блокировка оставалась эффективной.

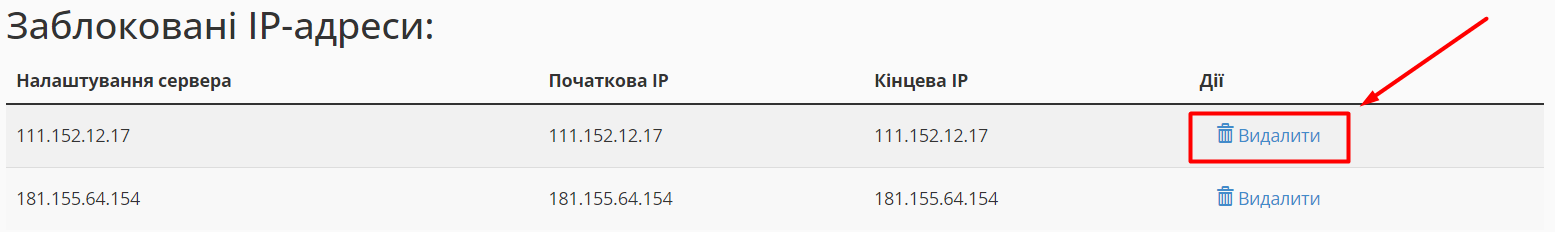

Блокировка IP через панель управления cPanel

Для блокировки IP адресов cPanel предоставляет возможность использовать собственный инструмент – IP Blocker (Блокировщик IP-адресов).

Чтобы заблокировать IP-адрес, выполните следующие шаги:

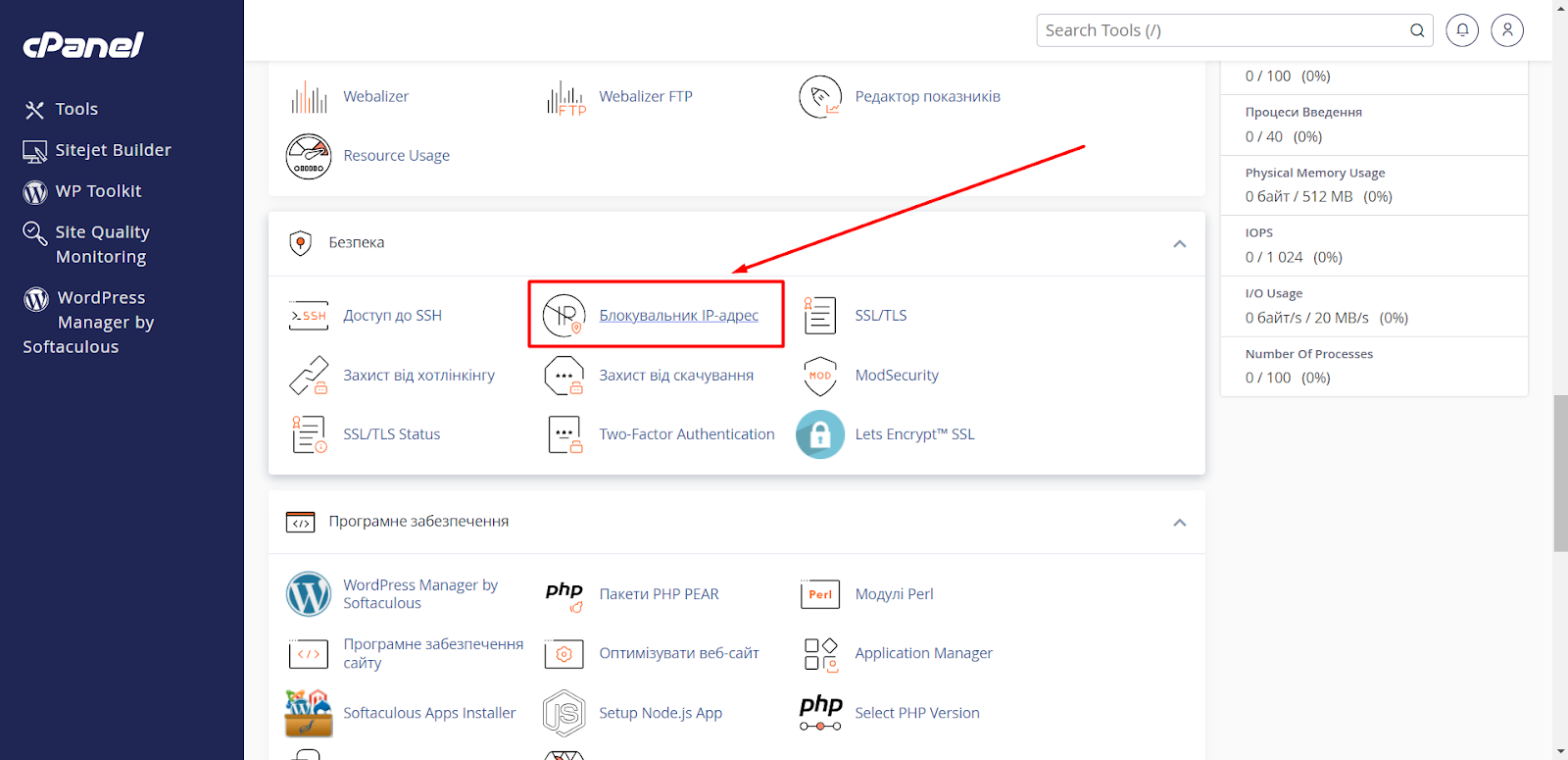

1. Войдите в свою панель управления cPanel и перейдите в раздел «Безопасность» ⇨ меню «Блокировщик IP».

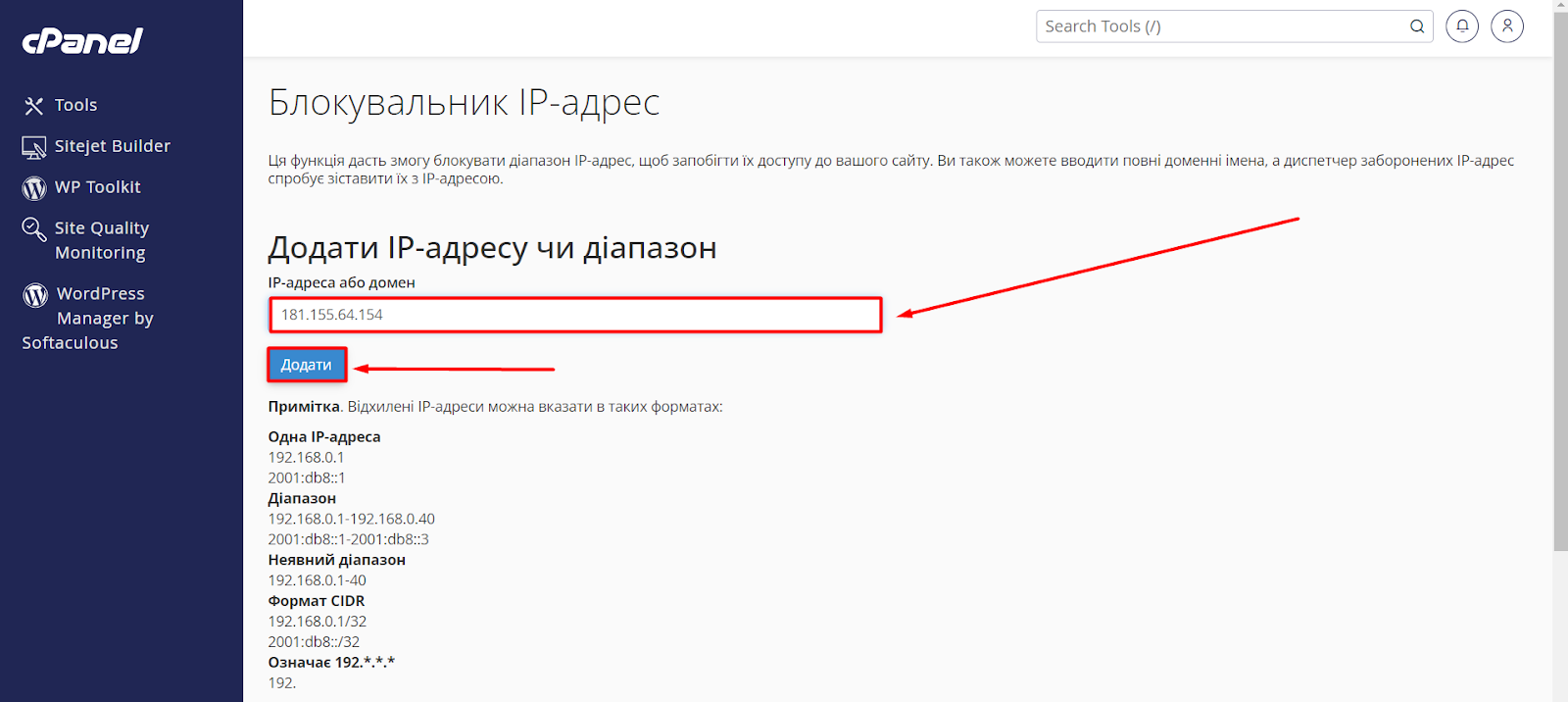

2. Введите IP-адрес, который нужно заблокировать, в поле IP-адрес или домен и нажмите кнопку «Добавить».

Он будет добавлен в список заблокированных IP-адресов.

Важно! Данный метод блокировки является аналогом ручной блокировки через файл .htaccess, ведь после блокировки IP адреса через панель управления, система автоматически добавляет адреса в ваш .htaccess файл.

Разблокировать IP-адрес

Вы всегда можете разблокировать IP-адрес, нажав «Удалить» рядом с соответствующим IP-адресом.

Блокировка вредоносных ботов в конфигурационных файлах

Блокировка ботов в конфигурационных файлах – это один из лучших способов защитить ваш веб-сайт от вредоносной активности. Блокировка ботов может осуществляется на уровне виртуальных хостов (vhosts). Это означает, что вы можете создать отдельные правила блокировки для каждого сайта на вашем сервере.

Важно! Блокировка вредоносных ботов в конфигурационных файлах применима исключительно для услуг VPS или для выделенных серверов.

Метод 1. Создание файла с правилами блокировки

Вы можете создать отдельный файл, содержащий правила блокировки вредоносных ботов, которые будут действовать для всех ваших веб-сайтов, размещенных на вашем сервере. Для этого следует выполнить несколько шагов:

- Создайте каталог includes (если его еще нет) по пути /etc/nginx/:

- Создайте файл, который будет содержать правила блокировки ботов. Вы можете назвать его как угодно. Например – block_bots.conf.

Важно! Название файла здесь не играет важной роли, главное – данный файл должен иметь расширение .conf. - В файле /etc/nginx/includes/block_bots.conf пропишите правила блокировки необходимого вам списка ботов.

Пример правила для блокировки вредоносных ботов:

if ($http_user_agent ~* Amazonbot|Claudebot|SeopultContentAnalyzer|SeekportBot|DataForSeoBot|Barkrowler|BLEXBot|SemrushBot|MJ12bot|AhrefsBot|bingbot|DotBot|PetalBot|LinkpadBot|SputnikBot|statdom. ru|MegaIndex.ru|WebDataStats|Jooblebot|Baiduspider|BackupLand|NetcraftSurveyAgent|openstat.ru) {

return 444;

}Объяснение правила:

- if ($http_user_agent ~* … ) – эта строка проверяет, содержит ли заголовок User-Agent в запросе любое из перечисленных имен ботов (разделенные |). Модификатор ~* указывает на соответствие регулярного выражения (любая часть строки User-Agent может содержать имя бота).

- Amazonbot|Claudebot|… – это список названий ботов, которые нужно блокировать.

- return 444; – это условие, при котором, если найден соответствующий User-Agent, Nginx вернет код состояния 444. Это специальный код, который вы можете определить в своем блоке сервера для обработки заблокированных запросов. Вы можете выбрать любой код между 400 (Плохой запрос) и 500 (Внутренняя ошибка сервера) для этой цели.

Важно! Этот код является лишь примером. Вам нужно будет его изменить в соответствии с вашими потребностями.

4. Включение правил блокировки в конфигурационные файлы vhosts.

В каждом файле vhost сайта укажите строку:

include /etc/nginx/includes/block_bots.conf;Таким образом вы «подключите» заданные вами правила блокировки. Выйдите и сохраните файл конфигурации, а чтобы изменения вступили в силу, перезагрузите веб-сервер nginx. Убедитесь, что ваша конфигурация nginx выглядит корректно, выполнив команду:

nginx -tЕсли ошибки не обнаружено, вы можете перезагрузить свою конфигурацию с помощью следующей команды:

service nginx reload или systemctl reload nginx(более длинный вариант, обновление только конфигурационных файлов, скорость обновления зависит от количества конфигурационных файлов)

или

service nginx restart(более быстрый вариант, но несколько секунд сайт может не работать)

Преимущество использования общего файла с правилами заключается в том, что вам не нужно будет редактировать каждый конфигурационный файл сайта отдельно при внесении изменений в список заблокированных ботов. Вы просто обновляете файл /etc/nginx/includes/block_bots.conf, и изменения применяются ко всем сайтам, где используется этот инклюд. Вы также можете создавать разные файлы инклюдов с правилами блокировки для разных групп сайтов.

Метод 2. Добавление правила блокировки в конфигурационный файл сайта

Этот метод позволяет заблокировать доступ к вашему сайту вредоносным ботам непосредственно в конфигурационном файле вашего сайта. Не рекомендуется для начинающих, поскольку может привести к проблемам с сайтом, если его настроить неправильно.

Для того, чтобы заблокировать вредоносных ботов с помощью конфигурационного файла вашего сайта, вы можете выполнить следующие шаги:

1. Откройте конфигурационный файл вашего сайта.

Вам нужно найти файл vhost для вашего сайта. Этот файл обычно находится в папке /etc/nginx/sites-available/ (для Nginx) или /etc/apache2/sites-available/ (для Apache).

2. Добавьте правило блокировки в файл.

Добавьте следующую строку к блоку server вашего сайта:

if ($http_user_agent ~* Amazonbot|Claudebot|SeopultContentAnalyzer|SeekportBot|DataForSeoBot|Barkrowler|BLEXBot|SemrushBot|MJ12bot|AhrefsBot|bingbot|DotBot|PetalBot|LinkpadBot|SputnikBot|statdom. ru|MegaIndex.ru|WebDataStats|Jooblebot|Baiduspider|BackupLand|NetcraftSurveyAgent|openstat.ru) {

return 444;

}3. Сохраните файл конфигурации.

4. Перезагрузите веб-сервер.

После выполнения этих шагов вредоносный бот с User-Agent, который вы указали, будет заблокирован от доступа к вашему сайту.

Эти методы описывают, как блокировать ботов на веб-сервере Nginx. Если вы используете другой веб-сервер, например Apache, LiteSpeed или OpenLiteSpeed, принцип может быть похож, но шаги настройки будут несколько иными.

Перед использованием метода блокировки ботов через конфигурационные файлы рекомендуется:

- создать резервную копию вашего конфигурационного файла;

- ознакомиться с основами работы с веб-серверами и конфигурационными файлами;

- обратиться за помощью к опытному пользователю или веб-производителю, если вы не уверены в своих силах.

CloudFlare – как инструмент для борьбы с вредоносным трафиком

CloudFlare – это сервис, который помогает улучшить безопасность и производительность вашего сайта. Он работает как посредник между вашим сайтом и посетителями, фильтруя трафик и обеспечивая более быструю доставку контента.

Чтобы воспользоваться всеми преимуществами CloudFlare, в том числе блокировкой вредоносных ботов, необходимо предварительно подключить его к вашему веб-сайту. CloudFlare предлагает несколько функций, которые можно использовать для блокировки ботов. Рассмотрим некоторые из них в бесплатной версии CloudFlare.

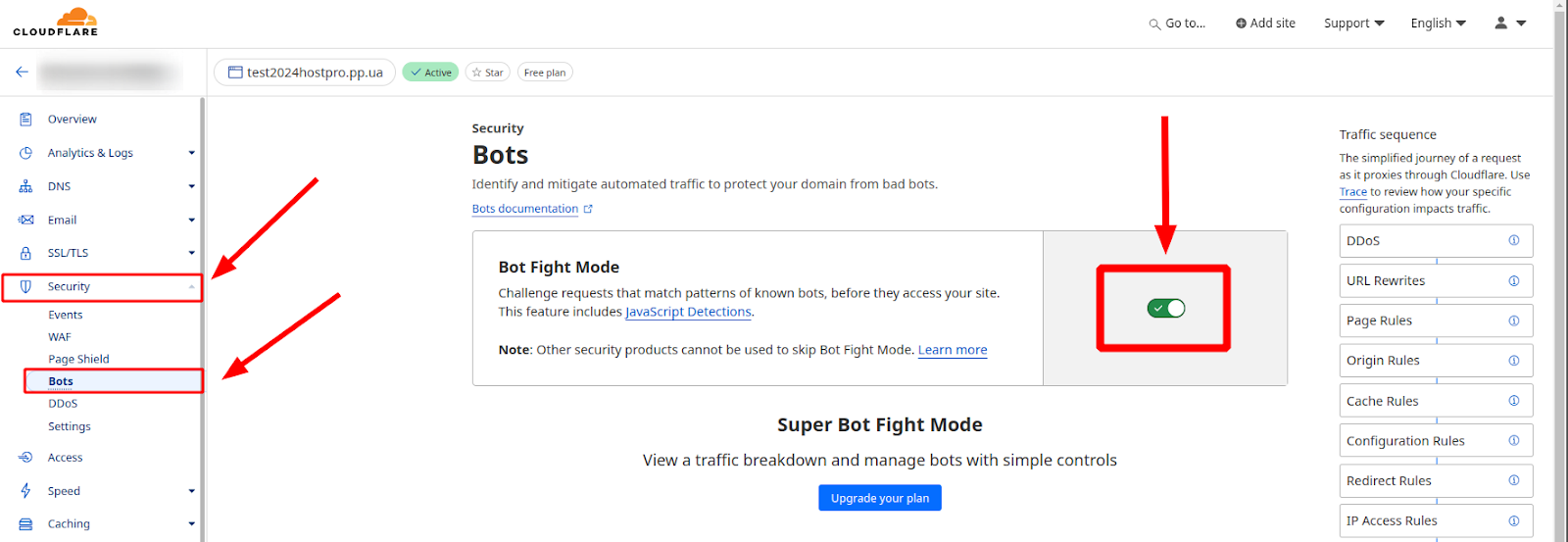

Режим Bot Fight Mode

CloudFlare Bot Fight Mode – это бесплатная функция, которая помогает идентифицировать и блокировать вредоносных ботов на вашем веб-сайте. Она анализирует трафик к вашему сайту и блокирует запросы, которые считаются подозрительными.

Как включить Bot Fight Mode?

- Войдите в свою учетную запись CloudFlare.

- Выберите домен, для которого нужно включить Bot Fight Mode.

- Перейдите в раздел «Безопасность» ⇨ «Блокировка ботов».

- Включите переключатель «Bot Fight Mode».

Поможет ли Bot Fight Mode в борьбе с вредоносными ботами?

Да, Bot Fight Mode может помочь вам в борьбе с вредоносными ботами, но это не гарантирует 100% защиты. Bot Fight Mode использует простой набор правил для идентификации ботов, поэтому некоторые сложные боты могут его обойти.

Для лучшей защиты рекомендуется использовать Bot Fight Mode вместе с другими функциями безопасности CloudFlare.

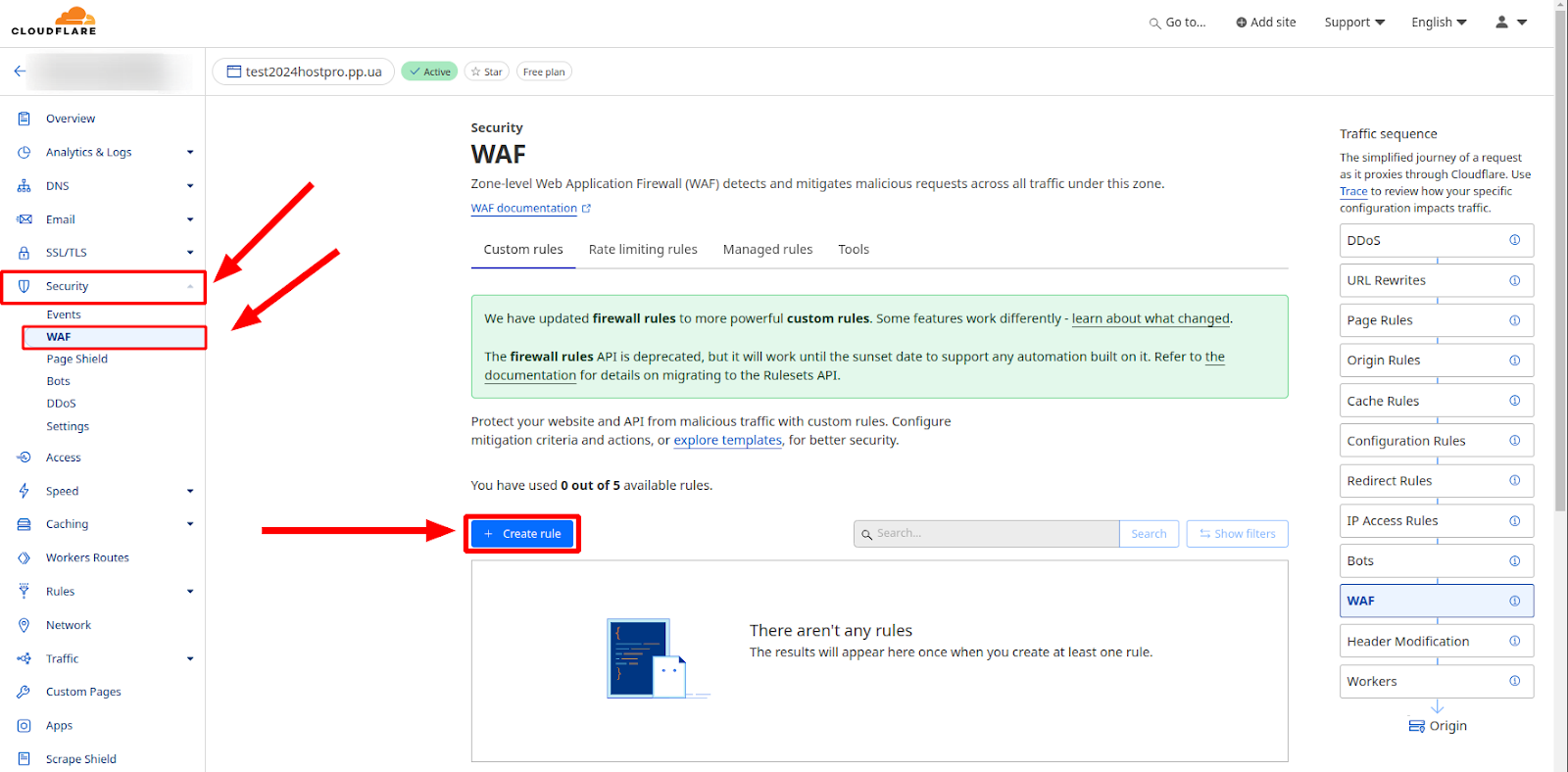

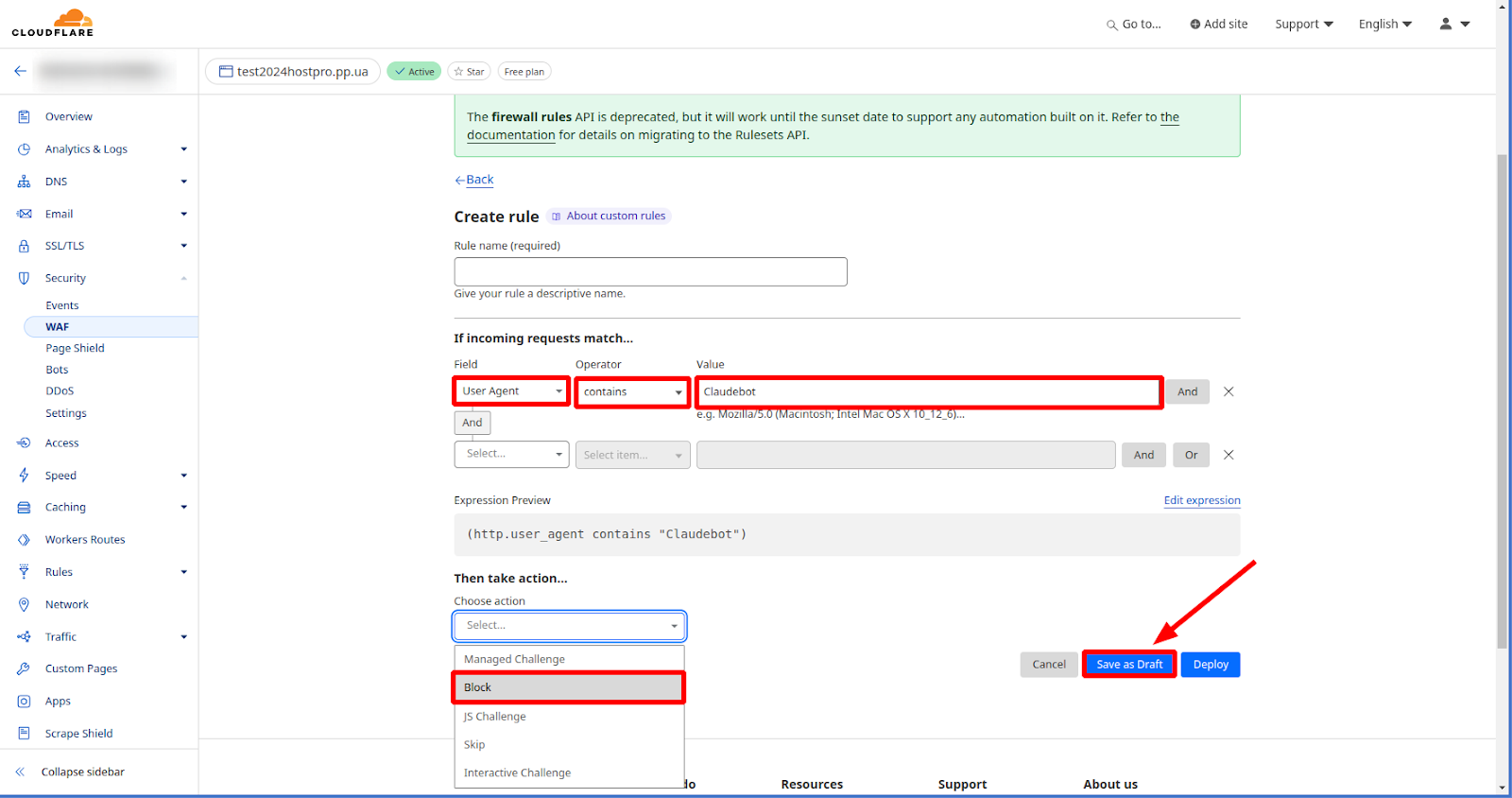

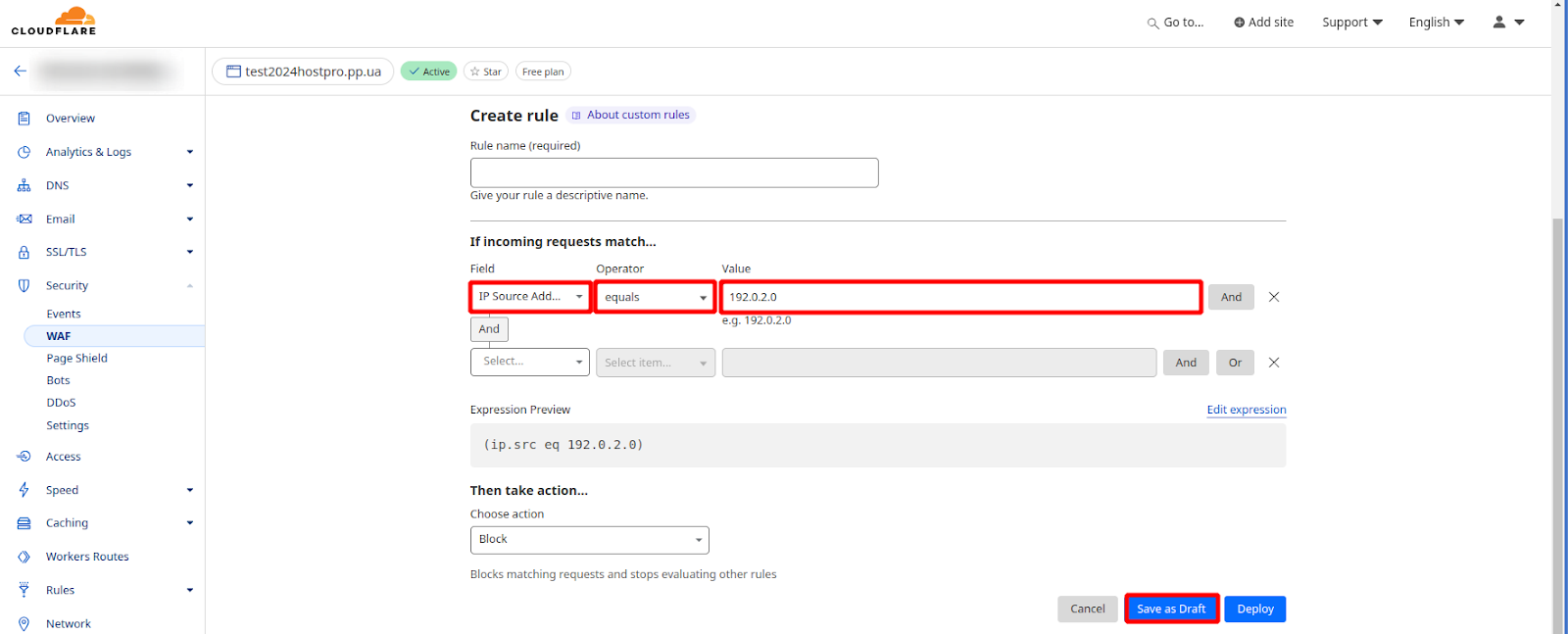

Брандмауэр CloudFlare (WAF)

Настройка правил брандмауэра CloudFlare дает владельцу веб-сайта широкий спектр возможностей для точного контроля над тем, какие HTTP-запросы могут их достигать. Брандмауэр CloudFlare является достаточно гибкой и интуитивно понятной системой, позволяющей создавать и настраивать правила в соответствии с вашими потребностями, обеспечивая максимальную защиту и лучший контроль над доступом к вашему контенту.

Блокировка ботов с помощью User Agent в Cloudflare WAF – это еще один эффективный способ защитить ваш веб-сайт от вредоносного трафика. Для этого нужно выполнить следующие шаги:

- Войдите в свою учетную запись Cloudflare.

- Перейдите на страницу WAF для своего домена в разделе «Безопасность».

- Нажмите кнопку «Создать правило».

- Выберите «User Agent» в качестве типа правила.

- В поле «Оператор» выберите отметку «contains».

- В поле «Значение» введите User Agent, который вы хотите заблокировать.

- Выберите, какое действие будет выполняться, когда WAF обнаружит соответствующий User Agent. Обычно выбирают «Блокировать».

- Нажмите кнопку «Сохранить».

Важно! Для блокировки отдельных IP-адресов выполняется аналогичная последовательность действий, только в качестве типа правила (пункт 4) выбирается соответственно пункт «IP Source Address» и в поле значения указывается IP-адрес, который нужно заблокировать.

Блокировка пользовательских агентов требует осторожного подхода. Регулярно анализируйте журналы своего веб-сайта и при необходимости корректируйте правила блокировки. Это поможет найти оптимальный баланс между безопасностью, производительностью и удобством для пользователей.

В завершение

В комплексе все описанные методы создают надежную систему защиты от вредоносных ботов, позволяя поддерживать стабильную работу веб-сайта и защищать его от потенциальных угроз.

Но важно помнить, что чрезмерная блокировка может привести к нежелательным последствиям, таким как ограничение доступа к сайту легитимным пользователям и поисковым системам. Это может негативно повлиять на SEO и снизить посещаемость ресурса. Поэтому важно сбалансировано подходить к настройке фильтров и правил блокировки, учитывая возможные положительные и отрицательные последствия.

Возможно, вас заинтересует

Как обнаружить вирусы на сайте и ликвидировать их с ImunifyAV+

Представьте, что вы заходите на свой веб-сайт и обнаруживаете, что он ведет себя странно...

| Обновлено: 17.06.2024

Файл robots.txt и как его правильно настроить

Robots.txt — это файл, который размещается в папке сайта на хостинге и запрещает поисковому...

| Обновлено: 29.05.2024

Как подключить к сайту Cloudflare

Из этого гайда вы узнаете, как подключить к сайту Cloudflare всего за несколько кликов....

| Обновлено: 16.08.2023

Шифрование: типы и алгоритмы. Что это, чем отличаются и где используются?

Многие до сих пор недооценивают важность SSL сертификатов, а ведь их технология лежит в...

| Обновлено: 16.06.2020

Наш телеграм

с важными анонсами, розыгрышами и мемами

Присоединиться